TED日本語

TED Talks(英語 日本語字幕付き動画)

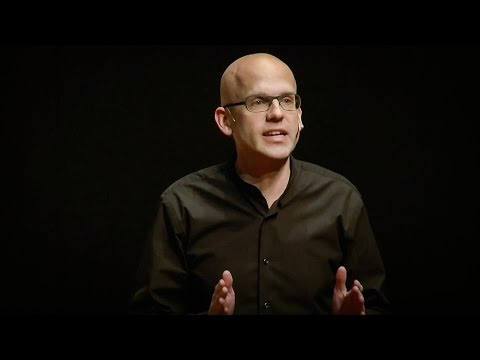

TED日本語 - ジェームズ・ブライドル: 悪夢のような子供向けYouTube動画 ― 今のインターネットのどこが間違っているのか

TED Talks

悪夢のような子供向けYouTube動画 ― 今のインターネットのどこが間違っているのか

The nightmare videos of children's YouTube -- and what's wrong with the internet today

ジェームズ・ブライドル

James Bridle

内容

作家で芸術家のジェームズ・ブライドルが、インターネットの暗く奇妙な片隅に光を当てます。そこでは誰とも分からぬ人々がYouTubeを使い、子供の頭を弄んで広告収入を得ています。サプライズ・エッグ開け動画やフィンガー・ファミリーの歌から、人気のアニメキャラが暴力的な状況に置かれるアルゴリズム的に生成されたマッシュアップ動画まであって、幼い心を食い物にし、怯えさせています。それは勢いを増すデータ駆動の世界がどこへ向かっているのかを示しているでしょう。ブライドルは言います。「テクノロジーがあらゆる問題への解決法だと思うのはやめて、問題が実際どういうものか知るためのガイドと考える必要があります。そうすれば問題を適切に捉え、取り組み始めることができるでしょう」

字幕

SCRIPT

Script

I'm James. I'm a writer and artist, and I make work about technology. I do things like draw life-size outlines of military drones in city streets around the world, so that people can start to think and get their heads around these really quite hard-to-see and hard-to-think-about technologies. I make things like neural networks that predict the results of elections based on weather reports, because I'm intrigued about what the actual possibilities of these weird new technologies are. Last year, I built my own self-driving car. But because I don't really trust technology, I also designed a trap for it.

(Laughter)

And I do these things mostly because I find them completely fascinating, but also because I think when we talk about technology, we're largely talking about ourselves and the way that we understand the world. So here's a story about technology.

This is a "surprise egg" video. It's basically a video of someone opening up loads of chocolate eggs and showing the toys inside to the viewer. That's it. That's all it does for seven long minutes. And I want you to notice two things about this. First of all, this video has 30 million views.

(Laughter)

And the other thing is, it comes from a channel that has 6.3 million subscribers, that has a total of eight billion views, and it's all just more videos like this -- 30 million people watching a guy opening up these eggs. It sounds pretty weird, but if you search for "surprise eggs" on YouTube, it'll tell you there's 10 million of these videos, and I think that's an undercount. I think there's way, way more of these. If you keep searching, they're endless. There's millions and millions of these videos in increasingly baroque combinations of brands and materials, and there's more and more of them being uploaded every single day. Like, this is a strange world. Right?

But the thing is, it's not adults who are watching these videos. It's kids, small children. These videos are like crack for little kids. There's something about the repetition, the constant little dopamine hit of the reveal, that completely hooks them in. And little kids watch these videos over and over and over again, and they do it for hours and hours and hours. And if you try and take the screen away from them, they'll scream and scream and scream. If you don't believe me -- and I've already seen people in the audience nodding -- if you don't believe me, find someone with small children and ask them, and they'll know about the surprise egg videos. So this is where we start. It's 2018, and someone, or lots of people, are using the same mechanism that, like, Facebook and Instagram are using to get you to keep checking that app, and they're using it on YouTube to hack the brains of very small children in return for advertising revenue.

At least, I hope that's what they're doing. I hope that's what they're doing it for, because there's easier ways of making ad revenue on YouTube. You can just make stuff up or steal stuff. So if you search for really popular kids' cartoons like "Peppa Pig" or "Paw Patrol," you'll find there's millions and millions of these online as well. Of course, most of them aren't posted by the original content creators. They come from loads and loads of different random accounts, and it's impossible to know who's posting them or what their motives might be. Does that sound kind of familiar? Because it's exactly the same mechanism that's happening across most of our digital services, where it's impossible to know where this information is coming from. It's basically fake news for kids, and we're training them from birth to click on the very first link that comes along, regardless of what the source is. That's doesn't seem like a terribly good idea.

Here's another thing that's really big on kids' YouTube. This is called the "Finger Family Song." I just heard someone groan in the audience. This is the "Finger Family Song." This is the very first one I could find. It's from 2007, and it only has 200,000 views, which is, like, nothing in this game. But it has this insanely earwormy tune, which I'm not going to play to you, because it will sear itself into your brain in the same way that it seared itself into mine, and I'm not going to do that to you. But like the surprise eggs, it's got inside kids' heads and addicted them to it. So within a few years, these finger family videos start appearing everywhere, and you get versions in different languages with popular kids' cartoons using food or, frankly, using whatever kind of animation elements you seem to have lying around. And once again, there are millions and millions and millions of these videos available online in all of these kind of insane combinations. And the more time you start to spend with them, the crazier and crazier you start to feel that you might be.

And that's where I kind of launched into this, that feeling of deep strangeness and deep lack of understanding of how this thing was constructed that seems to be presented around me. Because it's impossible to know where these things are coming from. Like, who is making them? Some of them appear to be made of teams of professional animators. Some of them are just randomly assembled by software. Some of them are quite wholesome-looking young kids' entertainers. And some of them are from people who really clearly shouldn't be around children at all.

(Laughter)

And once again, this impossibility of figuring out who's making this stuff -- like, this is a bot? Is this a person? Is this a troll? What does it mean that we can't tell the difference between these things anymore? And again, doesn't that uncertainty feel kind of familiar right now?

So the main way people get views on their videos -- and remember, views mean money -- is that they stuff the titles of these videos with these popular terms. So you take, like, "surprise eggs" and then you add "Paw Patrol," "Easter egg," or whatever these things are, all of these words from other popular videos into your title, until you end up with this kind of meaningless mash of language that doesn't make sense to humans at all. Because of course it's only really tiny kids who are watching your video, and what the hell do they know? Your real audience for this stuff is software. It's the algorithms. It's the software that YouTube uses to select which videos are like other videos, to make them popular, to make them recommended. And that's why you end up with this kind of completely meaningless mash, both of title and of content.

But the thing is, you have to remember, there really are still people within this algorithmically optimized system, people who are kind of increasingly forced to act out these increasingly bizarre combinations of words, like a desperate improvisation artist responding to the combined screams of a million toddlers at once. There are real people trapped within these systems, and that's the other deeply strange thing about this algorithmically driven culture, because even if you're human, you have to end up behaving like a machine just to survive.

And also, on the other side of the screen, there still are these little kids watching this stuff, stuck, their full attention grabbed by these weird mechanisms. And most of these kids are too small to even use a website. They're just kind of hammering on the screen with their little hands. And so there's autoplay, where it just keeps playing these videos over and over and over in a loop, endlessly for hours and hours at a time. And there's so much weirdness in the system now that autoplay takes you to some pretty strange places. This is how, within a dozen steps, you can go from a cute video of a counting train to masturbating Mickey Mouse. Yeah. I'm sorry about that. This does get worse. This is what happens when all of these different keywords, all these different pieces of attention, this desperate generation of content, all comes together into a single place. This is where all those deeply weird keywords come home to roost. You cross-breed the finger family video with some live-action superhero stuff, you add in some weird, trollish in-jokes or something, and suddenly, you come to a very weird place indeed.

The stuff that tends to upset parents is the stuff that has kind of violent or sexual content, right? Children's cartoons getting assaulted, getting killed, weird pranks that actually genuinely terrify children. What you have is software pulling in all of these different influences to automatically generate kids' worst nightmares. And this stuff really, really does affect small children. Parents report their children being traumatized, becoming afraid of the dark, becoming afraid of their favorite cartoon characters. If you take one thing away from this, it's that if you have small children, keep them the hell away from YouTube.

(Applause)

But the other thing, the thing that really gets to me about this, is that I'm not sure we even really understand how we got to this point. We've taken all of this influence, all of these things, and munged them together in a way that no one really intended. And yet, this is also the way that we're building the entire world. We're taking all of this data, a lot of it bad data, a lot of historical data full of prejudice, full of all of our worst impulses of history, and we're building that into huge data sets and then we're automating it. And we're munging it together into things like credit reports, into insurance premiums, into things like predictive policing systems, into sentencing guidelines. This is the way we're actually constructing the world today out of this data. And I don't know what's worse, that we built a system that seems to be entirely optimized for the absolute worst aspects of human behavior, or that we seem to have done it by accident, without even realizing that we were doing it, because we didn't really understand the systems that we were building, and we didn't really understand how to do anything differently with it.

There's a couple of things I think that really seem to be driving this most fully on YouTube, and the first of those is advertising, which is the monetization of attention without any real other variables at work, any care for the people who are actually developing this content, the centralization of the power, the separation of those things. And I think however you feel about the use of advertising to kind of support stuff, the sight of grown men in diapers rolling around in the sand in the hope that an algorithm that they don't really understand will give them money for it suggests that this probably isn't the thing that we should be basing our society and culture upon, and the way in which we should be funding it.

And the other thing that's kind of the major driver of this is automation, which is the deployment of all of this technology as soon as it arrives, without any kind of oversight, and then once it's out there, kind of throwing up our hands and going, "Hey, it's not us, it's the technology." Like, "We're not involved in it." That's not really good enough, because this stuff isn't just algorithmically governed, it's also algorithmically policed. When YouTube first started to pay attention to this, the first thing they said they'd do about it was that they'd deploy better machine learning algorithms to moderate the content. Well, machine learning, as any expert in it will tell you, is basically what we've started to call software that we don't really understand how it works. And I think we have enough of that already. We shouldn't be leaving this stuff up to AI to decide what's appropriate or not, because we know what happens. It'll start censoring other things. It'll start censoring queer content. It'll start censoring legitimate public speech. What's allowed in these discourses, it shouldn't be something that's left up to unaccountable systems. It's part of a discussion all of us should be having.

But I'd leave a reminder that the alternative isn't very pleasant, either. YouTube also announced recently that they're going to release a version of their kids' app that would be entirely moderated by humans. Facebook -- Zuckerberg said much the same thing at Congress, when pressed about how they were going to moderate their stuff. He said they'd have humans doing it. And what that really means is, instead of having toddlers being the first person to see this stuff, you're going to have underpaid, precarious contract workers without proper mental health support being damaged by it as well.

(Laughter)

And I think we can all do quite a lot better than that.

(Applause)

The thought, I think, that brings those two things together, really, for me, is agency. It's like, how much do we really understand -- by agency, I mean: how we know how to act in our own best interests. Which -- it's almost impossible to do in these systems that we don't really fully understand. Inequality of power always leads to violence. And we can see inside these systems that inequality of understanding does the same thing. If there's one thing that we can do to start to improve these systems, it's to make them more legible to the people who use them, so that all of us have a common understanding of what's actually going on here.

The thing, though, I think most about these systems is that this isn't, as I hope I've explained, really about YouTube. It's about everything. These issues of accountability and agency, of opacity and complexity, of the violence and exploitation that inherently results from the concentration of power in a few hands -- these are much, much larger issues. And they're issues not just of YouTube and not just of technology in general, and they're not even new. They've been with us for ages. But we finally built this system, this global system, the internet, that's actually showing them to us in this extraordinary way, making them undeniable. Technology has this extraordinary capacity to both instantiate and continue all of our most extraordinary, often hidden desires and biases and encoding them into the world, but it also writes them down so that we can see them, so that we can't pretend they don't exist anymore. We need to stop thinking about technology as a solution to all of our problems, but think of it as a guide to what those problems actually are, so we can start thinking about them properly and start to address them.

Thank you very much.

(Applause)

Thank you.

(Applause)

Helen Walters: James, thank you for coming and giving us that talk. So it's interesting: when you think about the films where the robotic overlords take over, it's all a bit more glamorous than what you're describing. But I wonder -- in those films, you have the resistance mounting. Is there a resistance mounting towards this stuff? Do you see any positive signs, green shoots of resistance?

James Bridle: I don't know about direct resistance, because I think this stuff is super long-term. I think it's baked into culture in really deep ways. A friend of mine, Eleanor Saitta, always says that any technological problems of sufficient scale and scope are political problems first of all. So all of these things we're working to address within this are not going to be addressed just by building the technology better, but actually by changing the society that's producing these technologies. So no, right now, I think we've got a hell of a long way to go. But as I said, I think by unpacking them, by explaining them, by talking about them super honestly, we can actually start to at least begin that process.

HW: And so when you talk about legibility and digital literacy, I find it difficult to imagine that we need to place the burden of digital literacy on users themselves. But whose responsibility is education in this new world?

JB: Again, I think this responsibility is kind of up to all of us, that everything we do, everything we build, everything we make, needs to be made in a consensual discussion with everyone who's avoiding it; that we're not building systems intended to trick and surprise people into doing the right thing, but that they're actually involved in every step in educating them, because each of these systems is educational. That's what I'm hopeful about, about even this really grim stuff, that if you can take it and look at it properly, it's actually in itself a piece of education that allows you to start seeing how complex systems come together and work and maybe be able to apply that knowledge elsewhere in the world.

HW: James, it's such an important discussion, and I know many people here are really open and prepared to have it, so thanks for starting off our morning.

JB: Thanks very much. Cheers.

(Applause)

私はジェームズ 作家で芸術家で テクノロジーに関する作品を 作っています 世界各地の街中に 実物大の軍用ドローンの輪郭を 描いたりしています こういう みんながあまり目にしたり 考えたりすることのないテクノロジーについて 考え 理解してもらえるように 天気予報に基づいて 選挙結果を予測する ニューラルネットなんかも 作っていますが それは こういう奇妙な新技術に 本当のところどんな可能性があるかに 興味があるからです 去年は自分で 自動運転車を作りました 私は技術というのを 信用していないので 一緒に自動運転車用の 罠も作りました

(笑)

私がそういったことをするのは 面白いと思うからですが 私達がテクノロジーの 話をするとき それは概ね 私達自身のことや 世界の理解の仕方についてだ ということもあります ではひとつ テクノロジーの 話をしましょう

これは「サプライズ・エッグ」の動画です 基本的には ただひたすら チョコの卵を開けて 中にあるオモチャを 見せるというものです それだけです 7分間ずっとそうしています ここで2点ほど 注意してほしいことがあります まず この動画の再生回数が 3千万回だということ

(笑)

もうひとつは この動画のチャンネルには 630万人の購読者がいることです 動画の総視聴回数は 80億回にもなりますが どれもがこれと 似たような動画です 3千万の人々が この人物が 卵を開けるのを見ているわけです すごく変な話に 聞こえるでしょうが YouTubeで「サプライズ・エッグ」を検索すると 1千万本あると出ます これは実際より 少ないと思います それより ずっとたくさん あるでしょう 検索していくと 際限なく出てきます 何百万という動画があり ブランドや素材の組み合わせが どんどん奇怪になっていきます そして新たな動画が 毎日追加されています まったく奇妙な世界です

問題は こういう動画を見ているのは 大人ではないことです 小さな子供なんです こういう動画は小さな子供にとって 麻薬みたいなものです 繰り返しに 何かあるらしく 明かされるたびに 小さなドーパミンの刺激があって すっかり惹き付けられて しまうんです 小さな子供はこういう動画を 何度も繰り返して再生し 何時間でも見続けます 取り上げようと しようものなら 泣き喚いて 手が付けられません 信じられないと言うなら ― 客席に頷いている方がいますが 小さな子供がいる人に 聞いてみてください サプライズ・エッグの動画を 知っているはずです これが出発点です 2018年現在 皆さんにアプリを チェックし続けさせるために FacebookやInstagramが使っているのと 同じ仕掛けを YouTubeに適用して 小さな子供の頭を弄び 広告収入を得ようとしている人が たくさんいるんです

少なくとも そうなのだと 思いたいです というのも YouTubeで 広告収入を得るためなら もっと簡単な方法が ありますから 単にでっち上げるか 盗むかすればいいんです 「ペッパ・ピッグ」や 「ポー・パトロール」のような 子供に人気のアニメを検索すると 何百万という動画が 見つかります そのほとんどは本当の作者が アップロードしたものではありません 山ほどの雑多なアカウントから 投稿されていて 誰がやっているのか 分からないし その動機も分かりません 聞いたことのあるような話ですね まったく同じことが 多くのデジタルサービスで 起きていて 情報がどこから来ているのか 分からないのです いわば子供のための フェイクニュースです 子供達は生まれた時から 出てくる最初のリンクを その出所を問わずクリックするよう 慣らされているのです あまり良い考えとは 思えませんが

これはまた別の すごく有名な 子供向けYouTube動画です 「フィンガー・ファミリーの歌」です 客席からうめきが 聞こえますね こちらがオリジナルらしく 私に見付けられた 最初のものです 2007年に公開され 視聴回数は20万回 この分野では 微々たるものです 耳から離れない音楽が 付いていますが ここでお聴かせはしません 頭にこびりついて 離れなくなりますから 私はそうなったので 皆さんを同じ目に 遭わせようとは思いません サプライズ・エッグと同じように 子供の頭に入り込んで 中毒にします 数年のうちに フィンガー・ファミリーの動画が 至る所に現れ始めました いろいろ変種があって 外国語版もあれば 人気の漫画キャラや 食べ物を使ったものもあり その辺にあるアニメの要素を 何でも使っています このような ありとあらゆる 突拍子のない取り合わせの動画が ネット上に山ほどあるんです そういうものを見始めると だんだん自分の気が狂っているような 感じがしてきます

私がこういうものを 調べ始めたのは この深い奇妙さの 感覚のためであり それがどうやって作られているのか あまりに謎だったからです これがどこからやってくるのか 知りようがありません いったい誰が作っているのか? プロのアニメーターの作のように 見えるものもあれば ソフトウェアでただランダムに 合成されたように見えるものもあり すごく健全な歌のお姉さん風の人が 出て来るものもあれば 子供には まったく近寄らせるべきでないような 人々によるものもあります

(笑)

誰が作っているのか 見当が付かないのです ボットなのか 人間なのか トロールなのか そういう違いがもはや 分からないというのは 何を意味するのか? この不確かさには 馴染みのある 感じが しないでしょうか?

動画の視聴者を集める 主なやり方は ― 視聴はお金を 意味するわけですが ― タイトルに人気の言葉を 入れるというものです たとえば「サプライズ・エッグ」に 「ポー・パトロール」とか 「イースター・エッグ」とか 何であれ他の人気動画の キーワードを付け加えるんです そうしていくと意味のない 言葉の寄せ集めになって 人間には意味をなさない ものになりますが こういう動画を見るのは 小さな子供なので どの道関係ありません これらのものの真の視聴者は ソフトウェア ― アルゴリズムなんです 動画をおすすめし 人気にしてくれる 似たビデオを選ぶ YouTubeのプログラムが ターゲットなんです そうやってタイトルも内容も 意味のない 混合物の動画が 出来上がります

でも このアルゴリズム的に 最適化されたシステムの中にも 依然として本物の人間がいることを 忘れてはいけません ますます奇抜になっていく 言葉の組み合わせに合わせて 演じることを強いられる 人々がいます 無数の幼児が同時に叫ぶ 言葉の組み合わせに 必死になって応じる 即興芸人みたいなものです このシステムの中に 囚われている人々がいるんです このアルゴリズム駆動の文化の 奇妙なところは ただ生き残るために 人間が機械のように 振る舞うことになる点です

そしてまた画面の反対側には 見ている小さな子供達がいて この奇妙なメカニズムに 心を奪われています そういう子供達の多くは小さくて ウェブサイトの使い方も分かりません 小さな手で ただ画面を叩くだけです 自動再生機能によって こういう動画が 繰り返し繰り返し 何時間も再生され続けます このシステムが 本当に変なのは 自動再生によって すごく奇妙なところへと 連れて行かれることです この例では 数を数える汽車の かわいい動画から始まって 10ステップほどで マスターベーションする ミッキーマウスに至っています 失敬しました でも これはもっと酷くなります 雑多なキーワードと 断片的な注目と やけくそのコンテンツ生成を ひとまとめにしたときに 起きるのは そういうことなんです 奇妙なキーワードの 連鎖が導く先です フィンガー・ファミリーの動画に 特撮ヒーローと 奇妙なトロール的 内輪ネタなんかを加えると ものすごく変な場所に至ります

子供の親を怒らせるのは 暴力的なものや 性的なものです 子供向けアニメのキャラが 襲われ 殺され 子供をただ怯えさせるような おふざけが展開されます そういったあらゆる刺激的なものを ソフトウェアが寄せ集めて 子供にとって最悪の悪夢を 生成しているんです そういうものは実際に 子供に影響を与えます 親御さんたちが報告しています 子供が心に傷を負ったとか 暗闇を恐れるようになったとか 好きだったアニメキャラを 怖がるようになったと ここから1つ学ぶことがあるとしたら 小さなお子さんがいるなら YouTubeには近寄るなということです

(拍手)

私を悩ませる もう1つのことは どうやって こんなことになったのか 私達が分かっていないということです あらゆる影響力 こういう ありとあらゆるものを取り上げ 誰も意図しなかったような仕方で まとめられていますが それはまた 私達が世界全体を 作っている方法でもあります あらゆるデータ 沢山のまずいデータや 偏見に満ち 最悪の衝動に満ちた 歴史的データを集めて 巨大なデータセットを作り 自動化しているのです それをまとめて 信用調査や 保険料や 犯罪予測や 量刑基準みたいなことに 使っています 今日の世界は データを使って 実際そのように 作られているのです どちらがより悪いことなのか 分かりません 人間の行動の最悪な面に 最適化されたシステムを 意図して作ったのか それとも 何をしているのか 分からずに 偶然そうなってしまったのか ― 自分の作っているシステムを 理解しておらず 他のやり方が 分からなかったために

それが特にYouTube上で 甚だしく起きているのには 2つの要因があります ひとつは 関心の収益化である広告で 実質的に他の要因が 働いておらず コンテンツを実際に 作っている人への配慮がなく 権力の集中も分離もない ということです 広告で利益を 得ることについて どう思っているにせよ オムツを履いた大の大人が 砂の上を転がり回って 本当には理解していないアルゴリズムが お金をくれることを 期待しているという光景は これが社会や文化の 基盤とすべきものでも 資金を得るべき方法でもないことを 示しているでしょう

主要なもう1つの要因は 自動化です やって来たらすぐに 何のチェックもなしに展開して 出した後は 手を挙げて言うんです 「俺のせいじゃない テクノロジーがやったことだ」と 「俺たちは関係ない」 とでも言うように それでは不十分です こういったものはアルゴリズムで 管理されているだけでなく アルゴリズムで検閲も されているからです YouTubeがこういう問題に 注意を向け始めたとき 彼らが言ったのは もっと良い 機械学習アルゴリズムを用意して 内容をチェックする ということでした 専門家なら みんな言うでしょうが 機械学習というのは どういう仕組みで動いているのか よく分からないソフトウェアのことです そういうのは もう十分にあります 何が適切かの判断を AIにまかせておくべきではありません どんなことが起こるか 分かっていますから 他のものも 検閲し始めるでしょう 奇妙な内容のものを検閲し ちゃんとした演説も 検閲し始めるでしょう どんな言論が許されるかは 無責任なシステムに まかせておくべき問題ではありません 私達みんなが 議論すべきことです

しかし代替案もまた あまり芳しいものでないことを 指摘しておきます すべて人間によって チェックした 子供向けのアプリを出すと 最近YouTubeが アナウンスしました Facebookも ザッカーバーグが 議会で同じようなことを モデレーションについて 聞かれたときに答えました そのための人間を用意すると それが意味するのは そういうものを最初に 目にすることになるのが 幼児の代わりに 低賃金で不安定な契約社員になり メンタルヘルス面での 支援もなく 被害を受けるということです

(笑)

もっとマシなことが できるはずです

(拍手)

この2つのことを まとめる考えは エージェンシーだと思います どれだけ本当に 理解しているかということ 最善の利益のため どう行動すればいいか いかに分かっているかということです こういう あまり理解していない システムにおいては ほとんど不可能なことです 力の不均衡は 暴力に繋がります こういったシステムの中では 理解の不均衡が 同じ結果を生みます こういうシステムを改善するために できることが1つあるとしたら 使う人々にもっと分かるものにする ということです 何が起きているのか みんな共通の理解を 得られるように

こういったシステムの問題は 前に言いましたように YouTubeに限ったこと ではありません あらゆるものに 当てはまります 説明責任やエージェンシー 透明性や複雑さ 暴力や搾取といった問題は 力が一部に集中していることの 結果であり それはずっと 大きな問題なのです YouTubeだけの問題ではないし テクノロジーだけの問題でもなく 新しい問題でさえありません ずっと昔からあったことです ただ我々がこの世界的なシステム インターネットを作ったことで 極端な形で現れるようになり 否定し得なくなった というだけです テクノロジーには ものすごい力があり 我々の最も甚だしい 隠された欲望や偏見に 形を与え継続させ 世界に刻みつけているのです しかし書き出されることで 目に見えるようになり もはや存在しないフリは できなくなりました テクノロジーがあらゆる問題への 解決法だと思うのはやめて 問題が実際どういうものか知るための ガイドと考える必要があります そうすれば 問題を適切に捉え 取り組み始める ことができるでしょう

ありがとうございました

(拍手)

ありがとうございます

(拍手)

(ヘレン・ウォルターズ)ジェームズ お話をありがとうございました 興味深いですね 人類がコンピューターに 支配される映画は あなたのお話よりも 華々しいですが そういう映画ではいつも レジスタンスが立ち上がります この問題に対して立ち上がる レジスタンスというのは いるのでしょうか? 抵抗が芽生える兆候に お気づきですか?

(ジェームズ・ブライドル)直接的な抵抗というのは知りません これはとても長期にわたる問題で 文化の中にすごく深く 入り込んでいます 友人のエレノア・サイッタが いつも言っていますが 十分大きなスケールと範囲を持つ テクノロジーの問題は 何よりもまず政治的問題なのです この問題に対処するため やるべきことは 単により良いテクノロジーを 作るということではなく そういうテクノロジーを生み出す社会を 変えるということでしょう 今はまだありません 道はものすごく長いと思います しかし言いましたように これを紐解き 説明し すごく率直に話すことで 少なくとも そのプロセスを 始めることはできます

(ヘレン)判読可能性や デジタル・リテラシーに触れたとき デジタル・リテラシーの重荷を ユーザー自身に負わせるというのは 難しいのではと思いました この新しい世界において 教育は誰の責任になるのでしょう?

(ジェームズ)繰り返しになりますが 責任は私達すべてにかかっています 私達のすることすべて 私達の作る物すべてが すべての人の議論による 同意のもと 作られる必要があります 正しいことを 引っかけたり驚くような仕方で やらせようとするのではなく みんなが教育の各段階に 関わる必要があります そういうシステムは 教育的なものですから そこが この滅入る問題に対し 私が希望を持っているところです 取り上げて 正しく見ることができるなら そこに学べるものがあり 複雑なシステムがどのように 出来上がるものか知ることができ その知識は他の所でも 役立つかもしれません

(ヘレン)とても大切な 話題だと思います ここにいる人の多くが 積極的に加わってくれるでしょう 朝一番に素晴らしい話を ありがとうございました

(ジェームズ)こちらこそ ありがとうございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

オンラインの嫌がらせコメントから、オフラインの建設的な対話を生む方法ディラン・マロン

2018.05.18

ネット広告の仕組みが拓く ディストピアへの道ジーナップ・トゥフェックチー

2017.11.17

壊れた報道の世界を救う3つの方法ララ・セトラキアン

2017.03.09

テロとの闘いで、権利を犠牲にする必要はないレベッカ・マッキノン

2016.10.14

インターネット検索結果に隠れた道徳的価値観アンドレアス・エクストローム

2015.12.07

謎のダークネットがメジャーになるときジェイミー・バートレット

2015.09.24

ネット炎上が起きるときジョン・ロンソン

2015.07.20

晒された屈辱の値段モニカ・ルインスキー

おすすめ 22015.03.20

インターネットで社会運動が容易になっても、目的達成は難しいのはなぜか?ジーナップ・トゥフェックチー

2015.02.02

スマートフォンがあったらライブ中継を始めようブルーノ・トートゥラ

2014.12.18

ソーシャルマップが街に住む人々の往来と、さらに分離を描き出すデーヴ・トロイ

2014.12.12

なぜプライバシーは重要なのかグレン・グリーンウォルド

2014.10.10

クリックするものを選ぼうサリー・コーン

2014.08.28

ウェブのための大憲章ティム・バーナーズ=リー

2014.08.18

カーリー・フライの謎解き ― ソーシャルメディアでの「いいね!」があなたの秘密を明かす?ジェニファー・ゴルベック

2014.04.03

なぜ優れたハッカーは良い市民となるのかキャサリン・ブレイシー

2014.02.25

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ダイナマイトビーティーエス

洋楽最新ヒット2020.08.20

ディス・イズ・ミーグレイテスト・ショーマン・キャスト

洋楽人気動画2018.01.11

グッド・ライフGイージー、ケラーニ

洋楽人気動画2017.01.27

ホワット・ドゥ・ユー・ミーン?ジャスティン・ビーバー

洋楽人気動画2015.08.28

ファイト・ソングレイチェル・プラッテン

洋楽人気動画2015.05.19

ラヴ・ミー・ライク・ユー・ドゥエリー・ゴールディング

洋楽人気動画2015.01.22

アップタウン・ファンクブルーノ・マーズ、マーク・ロンソン

洋楽人気動画2014.11.20

ブレイク・フリーアリアナ・グランデ

洋楽人気動画2014.08.12

ハッピーファレル・ウィリアムス

ポップス2014.01.08

カウンティング・スターズワンリパブリック

ロック2013.05.31

ア・サウザンド・イヤーズクリスティーナ・ペリー

洋楽人気動画2011.10.26

ユー・レイズ・ミー・アップケルティック・ウーマン

洋楽人気動画2008.05.30

ルーズ・ユアセルフエミネム

洋楽人気動画2008.02.21

ドント・ノー・ホワイノラ・ジョーンズ

洋楽人気動画2008.02.15

オンリー・タイムエンヤ

洋楽人気動画2007.10.03

ミス・ア・シングエアロスミス

ロック2007.08.18

タイム・トゥ・セイ・グッバイサラ・ブライトマン

洋楽人気動画2007.06.08

シェイプ・オブ・マイ・ハートスティング

洋楽人気動画2007.03.18

ウィ・アー・ザ・ワールド(U.S.A. フォー・アフリカ)マイケル・ジャクソン

洋楽人気動画2006.05.14

ホテル・カリフォルニアイーグルス

ロック2005.07.06