TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - ショーン・フォルマー: 形状変化テクノロジーが仕事を革新する

TED Talks

形状変化テクノロジーが仕事を革新する

Shape-shifting tech will change work as we know it

ショーン・フォルマー

Sean Follmer

内容

キーボードとマウスよりも進んだ世界は、どんなものでしょうか?インタラクション・デザイナーのショーン・フォルマーは、操作する指先で情報に生命を吹きこむことのできる機械で未来を形作っています。このトークで、3Dの形状変化テーブルや、リストバンドに変形する電話、形を変えることのできるゲームコントローラーなど、私たちの暮らしや仕事のやり方を変える可能性のあるものをご覧ください。

字幕

SCRIPT

Script

We've evolved with tools, and tools have evolved with us. Our ancestors created these hand axes 1.5 million years ago, shaping them to not only fit the task at hand but also their hand.

However, over the years, tools have become more and more specialized. These sculpting tools have evolved through their use, and each one has a different form which matches its function. And they leverage the dexterity of our hands in order to manipulate things with much more precision. But as tools have become more and more complex, we need more complex controls to control them. And so designers have become very adept at creating interfaces that allow you to manipulate parameters while you're attending to other things, such as taking a photograph and changing the focus or the aperture.

But the computer has fundamentally changed the way we think about tools because computation is dynamic. So it can do a million different things and run a million different applications. However, computers have the same static physical form for all of these different applications and the same static interface elements as well. And I believe that this is fundamentally a problem, because it doesn't really allow us to interact with our hands and capture the rich dexterity that we have in our bodies. And my belief is that, then, we must need new types of interfaces that can capture these rich abilities that we have and that can physically adapt to us and allow us to interact in new ways. And so that's what I've been doing at the MIT Media Lab and now at Stanford.

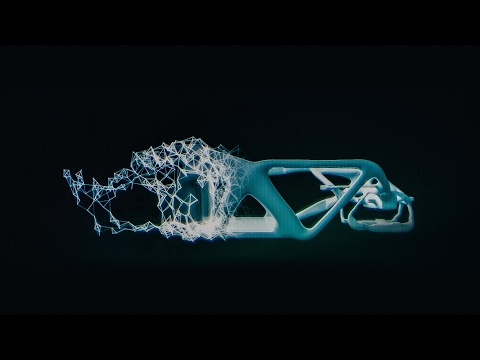

So with my colleagues, Daniel Leithinger and Hiroshi Ishii, we created inFORM, where the interface can actually come off the screen and you can physically manipulate it. Or you can visualize 3D information physically and touch it and feel it to understand it in new ways. Or you can interact through gestures and direct deformations to sculpt digital clay. Or interface elements can arise out of the surface and change on demand. And the idea is that for each individual application, the physical form can be matched to the application. And I believe this represents a new way that we can interact with information, by making it physical.

So the question is, how can we use this? Traditionally, urban planners and architects build physical models of cities and buildings to better understand them. So with Tony Tang at the Media Lab, we created an interface built on inFORM to allow urban planners to design and view entire cities. And now you can walk around it, but it's dynamic, it's physical, and you can also interact directly. Or you can look at different views, such as population or traffic information, but it's made physical.

We also believe that these dynamic shape displays can really change the ways that we remotely collaborate with people. So when we're working together in person, I'm not only looking at your face but I'm also gesturing and manipulating objects, and that's really hard to do when you're using tools like Skype. And so using inFORM, you can reach out from the screen and manipulate things at a distance. So we used the pins of the display to represent people's hands, allowing them to actually touch and manipulate objects at a distance. And you can also manipulate and collaborate on 3D data sets as well, so you can gesture around them as well as manipulate them. And that allows people to collaborate on these new types of 3D information in a richer way than might be possible with traditional tools. And so you can also bring in existing objects, and those will be captured on one side and transmitted to the other. Or you can have an object that's linked between two places, so as I move a ball on one side, the ball moves on the other as well. And so we do this by capturing the remote user using a depth-sensing camera like a Microsoft Kinect.

Now, you might be wondering how does this all work, and essentially, what it is, is 900 linear actuators that are connected to these mechanical linkages that allow motion down here to be propagated in these pins above. So it's not that complex compared to what's going on at CERN, but it did take a long time for us to build it. And so we started with a single motor, a single linear actuator, and then we had to design a custom circuit board to control them. And then we had to make a lot of them. And so the problem with having 900 of something is that you have to do every step 900 times. And so that meant that we had a lot of work to do. So we sort of set up a mini-sweatshop in the Media Lab and brought undergrads in and convinced them to do "research" --

(Laughter)

and had late nights watching movies, eating pizza and screwing in thousands of screws. You know -- research.

(Laughter)

But anyway, I think that we were really excited by the things that inFORM allowed us to do. Increasingly, we're using mobile devices, and we interact on the go. But mobile devices, just like computers, are used for so many different applications. So you use them to talk on the phone, to surf the web, to play games, to take pictures or even a million different things. But again, they have the same static physical form for each of these applications. And so we wanted to know how can we take some of the same interactions that we developed for inFORM and bring them to mobile devices.

So at Stanford, we created this haptic edge display, which is a mobile device with an array of linear actuators that can change shape, so you can feel in your hand where you are as you're reading a book. Or you can feel in your pocket new types of tactile sensations that are richer than the vibration. Or buttons can emerge from the side that allow you to interact where you want them to be. Or you can play games and have actual buttons. And so we were able to do this by embedding 40 small, tiny linear actuators inside the device, and that allow you not only to touch them but also back-drive them as well.

But we've also looked at other ways to create more complex shape change. So we've used pneumatic actuation to create a morphing device where you can go from something that looks a lot like a phone ... to a wristband on the go. And so together with Ken Nakagaki at the Media Lab, we created this new high-resolution version that uses an array of servomotors to change from interactive wristband to a touch-input device to a phone.

(Laughter)

And we're also interested in looking at ways that users can actually deform the interfaces to shape them into the devices that they want to use. So you can make something like a game controller, and then the system will understand what shape it's in and change to that mode.

So, where does this point? How do we move forward from here? I think, really, where we are today is in this new age of the Internet of Things, where we have computers everywhere -- they're in our pockets, they're in our walls, they're in almost every device that you'll buy in the next five years. But what if we stopped thinking about devices and think instead about environments? And so how can we have smart furniture or smart rooms or smart environments or cities that can adapt to us physically, and allow us to do new ways of collaborating with people and doing new types of tasks?

So for the Milan Design Week, we created TRANSFORM, which is an interactive table-scale version of these shape displays, which can move physical objects on the surface; for example, reminding you to take your keys. But it can also transform to fit different ways of interacting. So if you want to work, then it can change to sort of set up your work system. And so as you bring a device over, it creates all the affordances you need and brings other objects to help you accomplish those goals.

So, in conclusion, I really think that we need to think about a new, fundamentally different way of interacting with computers. We need computers that can physically adapt to us and adapt to the ways that we want to use them and really harness the rich dexterity that we have of our hands, and our ability to think spatially about information by making it physical. But looking forward, I think we need to go beyond this, beyond devices, to really think about new ways that we can bring people together, and bring our information into the world, and think about smart environments that can adapt to us physically. So with that, I will leave you.

Thank you very much.

(Applause)

私たちは道具と共に そして 道具も私たちと共に進化してきました 我々の祖先は150万年前に これらの握斧を作りましたが 目の前の仕事に合わせて 形作っただけでなく 自分たちの手の形にも合わせました

しかし 年月が過ぎると共に 道具はより専門化していきました これらの彫刻用の道具は 使われるうちに進化を遂げ それぞれが個々の機能に合った 形になりました これらは使う者の 手先の器用さを利用し さらに物体を正確に 加工できるようにしてくれます しかし 道具がより複雑になるにつれ 道具をコントロールするために より複雑な制御が必要になります そこでデザイナーは 様々なインターフェースを生み出すのに熟達し 私たちが他のことに取り組んでいる間にも 様々な要素を制御できるようにしました 例えば 写真を撮っている間に 焦点を変えたり 絞りを調節したりといった具合です

私たちの道具に対する考え方は コンピュータによって根本的に変わりました コンピュータの操作は強力だからです コンピュータは非常に多くの事柄を扱い 非常に多くのアプリケーションを 作動させられます しかし コンピュータは 様々なアプリケーションに対して 同じ物理的な形状を保ち インターフェースの要素も同じままです 私はこれは根本的に 問題であると考えています なぜなら これでは私たちは 手を使って意図を伝えたり 私たちの身体が持っている 器用さを捉えられないからです 私は新しいインターフェースが 必要なはずだと考えています 私たちの持つ豊かな能力を 捉えることができ 物理的に私たちに順応することができ 新しい方法で意図を伝えられるような インターフェースです 私はこうした研究を MIT メディアラボで そして現在は スタンフォード大学で行っています

私は同僚のダニエル・ライシンガーと 石井裕と一緒に 「inFORM(インフォーム)」を作りました インターフェースがスクリーンを離れて 物理的に操作できるものです あるいは 3D の情報を 物理的に視覚化することができ 直に触れることによって 新たな方法で理解できます ジェスチャーで意図を伝えたり 直接触って形状を変えて デジタル粘土を成形することもできます インターフェースの要素が 平面から飛び出してきて 必要に合わせて変化もします 基本的な考えとしては 個々の用途に合わせて 形状が変化しうるということです こうして 情報のやり取りを 物理的にすることにより 新たな情報との関わり方を 体現している と私は考えています

問題は これを どう利用できるかということです 伝統的に 都市プランナーや建築家は 都市や建物を理解するために それらの物理的なモデルを作ります そこでメディアラボのトニー・タンと一緒に inFORMを使ったインターフェースを作りました 都市プランナーが都市全体をデザインし 眺めることができるものです 今や都市の中を歩きまわることができます ダイナミックかつ物理的で 直接触れることもできます 他の視点から見ることもできます 例えば 人口や交通量など しかしこれも物理的に表現されます

こうした動的に形状が 変化するディスプレイによって 遠隔地の人々と共同作業する方法も 大きく変わると考えています 面と向かって 共同作業をしている時には 相手の顔を見ているだけでなく ジェスチャーをしたり 物体を動かしたりしますが これは Skype のようなツールを 使っている時には難しいことです inFORM を使えば スクリーンの向こうに手を伸ばして 遠くにある物体を動かすことができるのです ディスプレイ上のピンを使って 人の手を表して 遠くにある物体に実際に触れて 動かすことが可能になります 3D のデータセットも 手を加えたり 共同作業が可能で ジェスチャーでディスプレイを 操作することが可能です これによって 新しい種類の 3D情報において 伝統的なツールを用いたよりも 豊かな共同作業が可能になるのです 既存の物体を使うこともできます これは一方で入力されると もう一方で出力されます あるいは2つの場所と リンクされた物体を使えば 一方でボールが動けば もう一方でも動くようになります これは遠隔地のユーザーを Microsoft Kinect のような 奥行き感知カメラを使うことで 実現されています

これがどのように機能しているか 不思議にお思いでしょう 基本的には 900の リニアアクチュエータが このように機械的に連結しており 上部のピンに 動きを伝えているのです CERN で使われるような機械に比べれば さほど複雑ではありませんが 作るには長い時間がかかりました 最初は1つのモーターから始めました 1つのリニアアクチュエータです これを操作するための 独自の回路をデザインし これをたくさん作りました 900も同じ部品が あることの問題は 各段階を900回 繰り返す必要があることです 膨大な量の作業をこなしました メディアラボに ミニ作業場を作り 学部生を呼んできて 「研究」に携わるよう説得し

(笑)

夜遅くまで 映画を見たり ピザを食べながら 何千ものねじを止めていきました ほら 「研究」でしょう

(笑)

とにかく inFORM によって 可能になる事柄に 私たちは興奮しました 携帯機器の利用の増加により 私たちは常時やり取りができる状態にあります しかし 携帯機器は コンピュータと同様に 様々な用途に 用いられています 電話で話をするためや ネットサーフィンやゲーム 写真撮影など 他にもたくさんあります それでいて どの用途に対しても 物理的形状は同じです ですから inFORM 用に開発した やり取りを 携帯機器に応用したら どうなるかを知りたいと思いました

そこで スタンフォード大学で 触覚エッジ・ディスプレイを作りました これは形状を様々に変えることのできる リニア・アクチュエータのついた 携帯機器です 本を読みながら どこまで読んだかを触れて確認でき あるいはポケットの中で バイブレーションよりも豊かな 新しい感触を感じられます ボタンが側面から出てきて どこに表示するかを 選ぶこともできます ゲームをプレイする際に 実際に触れるボタンが出てきます これを実現するために 40の極小のリニア・アクチュエータを デバイスに備え付け それらを触れられるだけでなく それで操作することも できるようにしました

より複雑に形状を変化させる 他の方法にも注目しました 空気圧を用いることで 電話のように見えるものが 移動時には リストバンドになるデバイスを 作りました メディアラボの中垣拳と一緒に 高度に精密なバージョンを作りました サーボモーターによって インタラクティブなリストバンドが 入力装置になり 電話になるのです

(笑)

私たちはまた ユーザーが使いたいようなデバイスへと インターフェースを 変形できるような方法にも 関心を持っています ゲームコントローラーのような 形状を作ると システムがその形を認識し そのモードに切り替わるのです

これはどこへ向かっているのでしょう? ここからどう進めばいいのでしょう? 私が思うに 私たちは現在 「モノのインターネットの 新時代」にいます コンピュータがどこにでもあり ポケットの中や 壁の内部 これから5年間に皆さんが購入する ほぼすべてのデバイスに入っています でも デバイスについて 考えるのをやめて 環境について 考えてはどうでしょうか? どうしたら スマート家具や スマート部屋や スマート環境 ― スマート都市ができるでしょう? 私たちに物理的に適応でき 私たちが他者と 新しい方法で協力でき 新しい種類のタスクを 行えるようなものです

ミラノ・デザイン・ウィークに向けて TRANSFORM を作りました インタラクティブなテーブル大の ディスプレイで 表面にある物体を 動かすことができます 例えば 鍵を忘れないように してくれるなど 様々なインタラクションに合うよう 変形することも可能です 仕事をするなら 仕事場のような環境へと 変化します デバイスを近づけると その周囲に必要な構造を 作り出し 目標を達成できるように 他の物体を整えてくれます

結論としては 根本的に従来とは異なる 新たなコンピュータとの関わり方を 考える必要があると 私は考えています 物理的に私たちに適応し 使いたい用途に 適応してくれるような コンピュータが必要です 情報を物理的に表すことで 人間の手が持つ器用さと 空間認識能力を 活用できるようなコンピュータです しかし 将来を見据えると デバイスを超えて 人々をつなぎ 情報を世界に発信できるような 新しい方法を 考えなければなりません 私たちに物理的に適応する スマートな環境を考えるのです このアイデアを 皆さんにお伝えして終わりにします

ありがとうございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

10分で分かる量子コンピュータショヒーニ・ゴーシュ

2019.02.01

あなたの人生にサウンドトラックを付けてくれるAIピエール・バロー

2018.10.01

実在の人物の偽映像の作り方と、その見分け方スパソーン・スワジャナコーン

おすすめ 12018.07.25

AIはいかに人の記憶、仕事、社会生活を改善するかトム・グルーバー

2017.08.21

コンピューターはいかに物体を即座に認識できるようになったのかジョセフ・レドモン

2017.08.18

知性を持つ機械を恐れるな、協働せよガルリ・カスパロフ

2017.06.20

人工知能が人間を超えるのを怖れることはないグラディ・ブーチ

2017.03.13

直感を持った人工知能が生み出すすごい発明モーリス・コンティ

2017.02.28

表計算ソフト誕生の話ダン・ブリックリン

2017.02.01

機械知能は人間の道徳性をより重要なものにするゼイナップ・トゥフェックチー

2016.11.11

コンピューターはこうしてクリエイティブになるブレイス・アグエラ・ヤルカス

2016.07.22

Linuxの背後にある精神リーナス・トーバルズ

2016.05.03

ホログラム時代の未来にあるものアレックス・キップマン

2016.04.18

拡張現実ヘッドセットを通して未来を覗くメロン・グリベッツ

2016.04.11

インターネットをスクリーンなしで見るとトム・アグロ―

2015.11.13

顔を見るだけで感情がわかるアプリラナ・エル・カリウビ

2015.06.15

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ダイナマイトビーティーエス

洋楽最新ヒット2020.08.20

ディス・イズ・ミーグレイテスト・ショーマン・キャスト

洋楽人気動画2018.01.11

グッド・ライフGイージー、ケラーニ

洋楽人気動画2017.01.27

ホワット・ドゥ・ユー・ミーン?ジャスティン・ビーバー

洋楽人気動画2015.08.28

ファイト・ソングレイチェル・プラッテン

洋楽人気動画2015.05.19

ラヴ・ミー・ライク・ユー・ドゥエリー・ゴールディング

洋楽人気動画2015.01.22

アップタウン・ファンクブルーノ・マーズ、マーク・ロンソン

洋楽人気動画2014.11.20

ブレイク・フリーアリアナ・グランデ

洋楽人気動画2014.08.12

ハッピーファレル・ウィリアムス

ポップス2014.01.08

カウンティング・スターズワンリパブリック

ロック2013.05.31

ア・サウザンド・イヤーズクリスティーナ・ペリー

洋楽人気動画2011.10.26

ユー・レイズ・ミー・アップケルティック・ウーマン

洋楽人気動画2008.05.30

ルーズ・ユアセルフエミネム

洋楽人気動画2008.02.21

ドント・ノー・ホワイノラ・ジョーンズ

洋楽人気動画2008.02.15

オンリー・タイムエンヤ

洋楽人気動画2007.10.03

ミス・ア・シングエアロスミス

ロック2007.08.18

タイム・トゥ・セイ・グッバイサラ・ブライトマン

洋楽人気動画2007.06.08

シェイプ・オブ・マイ・ハートスティング

洋楽人気動画2007.03.18

ウィ・アー・ザ・ワールド(U.S.A. フォー・アフリカ)マイケル・ジャクソン

洋楽人気動画2006.05.14

ホテル・カリフォルニアイーグルス

ロック2005.07.06