TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - ヴィージェイ・クーマー: 空飛ぶロボットの未来

TED Talks

空飛ぶロボットの未来

The future of flying robots

ヴィージェイ・クーマー

Vijay Kumar

内容

ペンシルベニア大学の研究室で、ヴィージェイ・クーマーのチームは、蜜蜂の動きに触発された自律飛行ロボットを作りました。彼らの最新の成果は精密農業への応用で、ロボットの一群が、果樹園にある個々の果樹や果実を解析してモデルを作成し、収穫量を増やしたり、水の管理を改善する上で重要な情報を農家に提供するというものです。

字幕

SCRIPT

Script

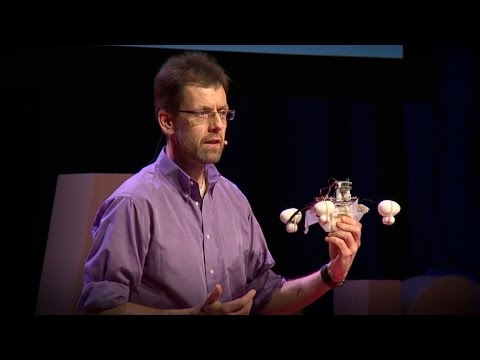

In my lab, we build autonomous aerial robots like the one you see flying here. Unlike the commercially available drones that you can buy today, this robot doesn't have any GPS on board. So without GPS, it's hard for robots like this to determine their position. This robot uses onboard sensors, cameras and laser scanners, to scan the environment. It detects features from the environment, and it determines where it is relative to those features, using a method of triangulation. And then it can assemble all these features into a map, like you see behind me. And this map then allows the robot to understand where the obstacles are and navigate in a collision-free manner.

What I want to show you next is a set of experiments we did inside our laboratory, where this robot was able to go for longer distances. So here you'll see, on the top right, what the robot sees with the camera. And on the main screen -- and of course this is sped up by a factor of four -- on the main screen you'll see the map that it's building. So this is a high-resolution map of the corridor around our laboratory. And in a minute you'll see it enter our lab, which is recognizable by the clutter that you see.

(Laughter)

But the main point I want to convey to you is that these robots are capable of building high-resolution maps at five centimeters resolution, allowing somebody who is outside the lab, or outside the building to deploy these without actually going inside, and trying to infer what happens inside the building.

Now there's one problem with robots like this. The first problem is it's pretty big. Because it's big, it's heavy. And these robots consume about 100 watts per pound. And this makes for a very short mission life. The second problem is that these robots have onboard sensors that end up being very expensive -- a laser scanner, a camera and the processors. That drives up the cost of this robot.

So we asked ourselves a question: what consumer product can you buy in an electronics store that is inexpensive, that's lightweight, that has sensing onboard and computation? And we invented the flying phone.

(Laughter)

So this robot uses a Samsung Galaxy smartphone that you can buy off the shelf, and all you need is an app that you can download from our app store. And you can see this robot reading the letters, "TED" in this case, looking at the corners of the "T" and the "E" and then triangulating off of that, flying autonomously. That joystick is just there to make sure if the robot goes crazy, Giuseppe can kill it.

(Laughter)

In addition to building these small robots, we also experiment with aggressive behaviors, like you see here. So this robot is now traveling at two to three meters per second, pitching and rolling aggressively as it changes direction. The main point is we can have smaller robots that can go faster and then travel in these very unstructured environments.

And in this next video, just like you see this bird, an eagle, gracefully coordinating its wings, its eyes and feet to grab prey out of the water, our robot can go fishing, too.

(Laughter)

In this case, this is a Philly cheesesteak hoagie that it's grabbing out of thin air.

(Laughter)

So you can see this robot going at about three meters per second, which is faster than walking speed, coordinating its arms, its claws and its flight with split-second timing to achieve this maneuver. In another experiment, I want to show you how the robot adapts its flight to control its suspended payload, whose length is actually larger than the width of the window. So in order to accomplish this, it actually has to pitch and adjust the altitude and swing the payload through. But of course we want to make these even smaller, and we're inspired in particular by honeybees. So if you look at honeybees, and this is a slowed down video, they're so small, the inertia is so lightweight --

(Laughter)

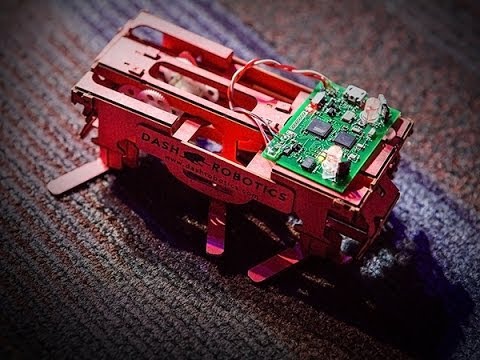

that they don't care -- they bounce off my hand, for example. This is a little robot that mimics the honeybee behavior. And smaller is better, because along with the small size you get lower inertia. Along with lower inertia --

along with lower inertia, you're resistant to collisions. And that makes you more robust. So just like these honeybees, we build small robots. And this particular one is only 25 grams in weight. It consumes only six watts of power. And it can travel up to six meters per second. So if I normalize that to its size, it's like a Boeing 787 traveling ten times the speed of sound.

(Laughter)

And I want to show you an example. This is probably the first planned mid-air collision, at one-twentieth normal speed. These are going at a relative speed of two meters per second, and this illustrates the basic principle. The two-gram carbon fiber cage around it prevents the propellers from entangling, but essentially the collision is absorbed and the robot responds to the collisions. And so small also means safe. In my lab, as we developed these robots, we start off with these big robots and then now we're down to these small robots. And if you plot a histogram of the number of Band-Aids we've ordered in the past, that sort of tailed off now. Because these robots are really safe.

The small size has some disadvantages, and nature has found a number of ways to compensate for these disadvantages. The basic idea is they aggregate to form large groups, or swarms. So, similarly, in our lab, we try to create artificial robot swarms. And this is quite challenging because now you have to think about networks of robots. And within each robot, you have to think about the interplay of sensing, communication, computation -- and this network then becomes quite difficult to control and manage. So from nature we take away three organizing principles that essentially allow us to develop our algorithms. The first idea is that robots need to be aware of their neighbors. They need to be able to sense and communicate with their neighbors.

So this video illustrates the basic idea. You have four robots -- one of the robots has actually been hijacked by a human operator, literally. But because the robots interact with each other, they sense their neighbors, they essentially follow. And here there's a single person able to lead this network of followers. So again, it's not because all the robots know where they're supposed to go. It's because they're just reacting to the positions of their neighbors.

(Laughter)

So the next experiment illustrates the second organizing principle. And this principle has to do with the principle of anonymity. Here the key idea is that the robots are agnostic to the identities of their neighbors. They're asked to form a circular shape, and no matter how many robots you introduce into the formation, or how many robots you pull out, each robot is simply reacting to its neighbor. It's aware of the fact that it needs to form the circular shape, but collaborating with its neighbors it forms the shape without central coordination. Now if you put these ideas together, the third idea is that we essentially give these robots mathematical descriptions of the shape they need to execute. And these shapes can be varying as a function of time, and you'll see these robots start from a circular formation, change into a rectangular formation, stretch into a straight line, back into an ellipse. And they do this with the same kind of split-second coordination that you see in natural swarms, in nature.

So why work with swarms? Let me tell you about two applications that we are very interested in. The first one has to do with agriculture, which is probably the biggest problem that we're facing worldwide. As you well know,one in every seven persons in this earth is malnourished. Most of the land that we can cultivate has already been cultivated. And the efficiency of most systems in the world is improving, but our production system efficiency is actually declining. And that's mostly because of water shortage, crop diseases, climate change and a couple of other things.

So what can robots do? Well, we adopt an approach that's called Precision Farming in the community. And the basic idea is that we fly aerial robots through orchards, and then we build precision models of individual plants. So just like personalized medicine, while you might imagine wanting to treat every patient individually, what we'd like to do is build models of individual plants and then tell the farmer what kind of inputs every plant needs -- the inputs in this case being water, fertilizer and pesticide. Here you'll see robots traveling through an apple orchard, and in a minute you'll see two of its companions doing the same thing on the left side. And what they're doing is essentially building a map of the orchard. Within the map is a map of every plant in this orchard.

(Robot buzzing)

Let's see what those maps look like. In the next video, you'll see the cameras that are being used on this robot. On the top-left is essentially a standout color camera. On the left-center is an infrared camera. And on the bottom-left is a thermal camera. And on the main panel, you're seeing a three-dimensional reconstruction of every tree in the orchard as the sensors fly right past the trees. Armed with information like this, we can do several things. The first and possibly the most important thing we can do is very simple: count the number of fruits on every tree. By doing this, you tell the farmer how many fruits she has in every tree and allow her to estimate the yield in the orchard, optimizing the production chain downstream.

The second thing we can do is take models of plants, construct three-dimensional reconstructions, and from that estimate the canopy size, and then correlate the canopy size to the amount of leaf area on every plant. And this is called the leaf area index. So if you know this leaf area index, you essentially have a measure of how much photosynthesis is possible in every plant, which again tells you how healthy each plant is. By combining visual and infrared information, we can also compute indices such as NDVI. And in this particular case, you can essentially see there are some crops that are not doing as well as other crops. This is easily discernible from imagery, not just visual imagery but combining both visual imagery and infrared imagery.

And then lastly,one thing we're interested in doing is detecting the early onset of chlorosis -- and this is an orange tree -- which is essentially seen by yellowing of leaves. But robots flying overhead can easily spot this autonomously and then report to the farmer that he or she has a problem in this section of the orchard.

Systems like this can really help, and we're projecting yields that can improve by about ten percent and, more importantly, decrease the amount of inputs such as water by 25 percent by using aerial robot swarms.

Lastly, I want you to applaud the people who actually create the future, Yash Mulgaonkar, Sikang Liu and Giuseppe Loianno, who are responsible for the three demonstrations that you saw.

Thank you.

(Applause)

私の研究室では ご覧のような 自律飛行ロボットを作っています 今時 お店で売っているような ドローンとは違って GPSは搭載していません GPSなしでは このようなロボットが 自分の位置を特定するのは困難です このロボットの場合 搭載したセンサー、カメラ、レーザースキャナーで 周囲を走査していて 周りにあるものを検知し 三角測量によって それらに対する 相対的な位置を把握しています それらのデータをまとめて 後ろに出ているような マップを構築することが出来ます こうやってマップができると どこに障害物があるか分かり ロボットは衝突することなく 飛行することが出来ます

次にお見せしたいのは このロボットに もっと長い距離を飛行させてみた 私たちの研究所で行った 一連の実験です 右上にあるのは ロボットのカメラが撮った映像です メインスクリーンでは ― 4倍速でお見せしていますが ― マップ構築の様子をご覧になれます これは研究室周辺の廊下を 高解像度でマップ化したもので まもなく研究室へと入ってきます 散らかっている様子で それと分かるかと思いますが ―

(笑)

ここで最も強調したいのは これらのロボットは 5センチという高い解像度で マップを作成することが 出来るということで 研究室や建物の外部にいる人でも このロボットを放つことで 実際に中に入ることなく 中で何が起こっているか 推察することができます

このようなロボットには 問題点があります 1つ目の問題は 大きいということです 大きいので重量もあります 1キログラムにつき約200ワットの 電力を消費します ですからあまり長くは作業できません 2つ目の問題は ロボットに搭載されている レーザースキャナーやカメラや CPUがとても高価だということです そのためロボットのコストが 跳ね上がります

そこで私達は自問しました 消費者が電気屋で買えるような センサーやCPUを搭載した 高価でない軽量な商品はないだろうか? そうやって空飛ぶ携帯電話が 生まれました

(笑)

このロボットは お店ですぐに買える サムスンのギャラクシー携帯を利用し アプリはAppストアから ダウンロードできます このロボットは 今 「TED」の文字を読み取っているところです 「T」と「E」の角を探し出し 三角測量しつつ自律飛行しています ジョイスティックは ロボットが暴走した時のためで その時にはジュゼッペ君が 止めてくれます

(笑)

単に小さなロボットを 作るというだけでなく このような激しい動きをさせる 実験もしています このロボットは秒速2~3メートルで動き 方向転換をするときには 上下運動や回転運動を素早く行います 重要な点は 小さなロボットは 素早く動け 障害の多い環境中を うまく移動できることです

次のビデオでお見せするのは 鷲のような鳥が 羽と目と足を優雅に連携させて 水中の獲物を捉まえるように 私たちのロボットにも 魚採りができることです

(笑)

どこからともなくやって来て チーズ & ステーキのロールパンサンドを

かっさらっています (笑)

このロボットは人の歩く速さよりも速い 秒速約3メートルで動き 腕と爪と飛行を 絶妙なタイミングで連携させ このような動作を達成しています 別の実験でお見せするのは 枠の幅よりも長い紐で 重りを吊したロボットが その枠の中を 上手くくぐり抜ける様子です これを成し遂げるには 上下に動いて 高度を調整することで 重りをスイングさせる 必要があります しかし もっと小さいものが 作れたらと思っています 特にミツバチにヒントを得ました これはスローモーションで 再生したビデオですが ミツバチはとても小さく その慣性力は僅かです

(笑)

例えば 私の手にぶつかっても ほとんど気にかけません これはミツバチの動きをまねた 小型ロボットです 小さいほど 慣性力が小さくなるので 都合がいいのです 慣性力が小さいと ―

(周りをブンブン飛び回るロボット) (笑)

慣性力が小さいと 衝突に対し強くなります より丈夫になるということです そういうわけでミツバチのように 小さなロボットを作ります これは僅か25グラムしかありません 消費電力はほんの6ワットです 秒速6メートルまで出せます ボーイング787の大きさだったら 音速の10倍に相当する速さです

(笑)

実例をお見せしましょう これはたぶん初めての空中衝突実験で 20分の1のスピードでお見せしています (ロボット同士の)相対速度は 毎秒2メートルで お話しした基本原理を例示しています 機体を保護する2グラムの炭素繊維のカゴは プロペラ同士が絡まるのを防いでいます 衝撃は吸収され ロボットは衝突に対応しています 小さいということは安全も意味します 研究室ではこんなロボットを作ってきました 大型のロボットから始め 小型のものへと移っていきました これまで研究室で発注した絆創膏の数を ヒストグラムにしたら どんどん小さくなっていることが 分るでしょう ロボットが安全になってきたからです

小さいと不利な点もあります 自然はこの不利な点を補う方法を 進化させてきました 基本的には集団や群れを作る ということです 我々の研究室でも 同様に 人工的なロボットの集団を試してみました これはかなり難しい技術です ロボット間のネットワークを 考慮しなければならないからです 各ロボットの センサー、通信、計算の 連携を考えなければなりません このネットワークの制御、管理が 実にやっかいなのです 自然から3つの(自己)組織化の原理を 見習うことによって 制御のアルゴリズムを 開発することができます 1つ目のアイデアは ロボットが近くの個体を認識することです 近隣の個体を認識して 互いに通信できなければなりません

このビデオはその基本原理を示しています 4機のロボットがいます その内1機が 文字通り 人間のオペレータによってハイジャックされています ロボットは互いに相互作用し 近くの個体を認識しているので 動きに追従します この例では1人の人間が 追従するロボットを先導しています どのロボットもどこへ行くべきか 分っているわけではなく ただ近くのロボットの位置に対し 反応しているだけです

(笑)

次の実験は 組織化の2つ目の原理を示すものです この原理は匿名性の原理と関連しています ここで基本となる考えは ロボットは近隣の個体を 識別していないということです 円陣を組めという指令を受けると 編隊を組むロボットの数を いかに増やそうと あるいは 何体か取り除こうと 各ロボットは単に 隣にいるロボットに反応するだけなのです 円陣を組むという 指示を受けるものの 隣のロボットと協調するだけで 中央制御によって 編隊を形成しているわけではありません これらのアイデアを一緒にすると 3つ目のアイデアが得られます ロボットに編隊の形の 数学的記述を与えるということです 形は時間と共に変わっていきます ご覧の様に 円形から始まり 長方形を形作った後 直線状に広がり また楕円に戻ります 自然界における生物の群れと同様に 瞬間瞬間の協調によって こういったことを成し遂げています

なぜ群れについて研究しているのか? 我々がとても興味を抱いている 2つの応用があります 1つ目は農業に関するものです 我々が世界で直面している 最大の問題と言って良いでしょう ご存知の通り 世界では 7人に1人が栄養失調です 耕作可能な土地は 既に殆ど開拓されています こんにちの世界では 多くのシステムの効率が向上していますが 農業の生産効率は低下しています 原因はおそらく 水不足、穀物の病気 気候変動や その他の理由にあります

ロボットに何が出来るでしょう? この分野で精密農業(プレシジョンファーミング) と呼ばれる手法を取り入れてみました 基本的な考えはこうです 果樹園にロボットを飛ばし 個々の木の精密なモデルを作成します 個々の患者の 遺伝体質に合わせた オーダーメード医療のように 個々の木のモデルを製作することによって 農家はそれぞれの木が必要とするもの ― この場合 水、肥料や殺虫剤といったものですが それを知ることができます ロボットがリンゴ園を飛び交っています 仲間の2機が同じようなことを しているのが すぐに 左手に見えてきます 果樹園のマップを作成しているところで 果樹園にある1本1本の木を マッピングしています

(ブンブン)

ではそのマップを見てみましょう 次のビデオではロボットに搭載された カメラの映像をご覧になれます 左上は通常のカラー映像です 左中央は赤外線映像で 左下はサーマルカメラのものです 中央のパネルでは 各センサーが木々を通過するのに合わせ 果樹園の木の状態が 3次元的に再構成されていく様子が見られます こういった情報を用いて 多くのことが出来ます 1つ目はおそらく最も重要なことですが とても単純なこと 木になっている果実の数を 数えるということです これによって農家は 個々の木になる果実の数を知り 果樹園全体の収穫量を見積もり 生産販売経路を 最適化することができます

2つ目に可能なことは 木のモデルに基づき 3次元形状を再構成し そこから樹冠の面積を 推定することで 土地単位面積あたりの 葉面積を求めるということです これは葉面積指数と呼ばれます 葉面積指数は それぞれの木がどれだけの光合成を 行っているかの指標となり 個々の木の健康度を示します 可視光と赤外線データを組み合わせると 正規化植生指標といった指標を 計算することができます ご覧の例では ある作物が他の作物に比べて 状態が悪いことが見て取れます これは通常の可視光だけでなく 可視光と赤外線イメージを 組み合わせることで 容易に識別できるようになります

最後に 我々が関心を持っているのは 植物の黄白化の早期発見です これはオレンジの木です 葉が黄色くなっています 上空にロボットを飛ばすことで これは自動で容易に発見できます そして果樹園のこの区域に 異常があることを 農家に知らせます

このようなシステムはとても有効で 10%の収穫量増加が期待できますが さらに重要なのは 飛行ロボットを使うことで 水の25%削減など 投入資源を減らせることです

最後になりますが 未来を創造する この人達に拍手をお願いしたいと思います ヤッシュ・ムルガンカー、シカン・リウ、ジュゼッペ・ロイアーノ 彼らがご覧になった3つのデモを 作成してくれました

有難うございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

しなやかで柔軟性を持つロボットの驚くべき可能性 - TED Talkジアーダ・ゲルボーニ

2018.07.05

ロボットの気持ちを考える ― 人間とロボットの共存社会を目指してレイラ・タカヤマ

2018.02.16

魚の群れから学習する知能機械ラディカ・ナグパール

2017.10.06

ロボットは大学入試に合格できるか?新井紀子

おすすめ 12017.09.13

走って飛び跳ねて、ドアも開けられるロボット犬「スポット」マーク・レイバート

2017.08.14

汚染物資を「食べる」ロボットジョナサン・ロシター

2017.03.15

魅惑的な未来の飛行ロボットを披露ラファエロ・ダンドリーア

2016.03.11

イモリの様に走り、泳ぐことのできるロボットアウケ・エイスペールト

2016.02.18

米粒のサイズのロボットを作る理由サラ・バーグブライター

2015.01.21

空飛ぶカメラ、ただしリード付きセルゲイ・ルパシン

2014.10.28

自然界で最も不快な生き物にヒントを得たロボットロバート・フル

2014.06.06

「心」を宿したロボットガイ・ホフマン

2014.01.17

私の水中探査ロボットデイビッド・ラング

2013.12.05

なぜ、私たちはロボットに頼ることになるのかロドニー・ブルックス

2013.06.28

クアッドコプターの驚くべき運動能力ラファエロ・ダンドリーア

2013.06.11

あなたの携帯をパーソナル・ロボットに変える発明ケラー・リナウド

2013.04.09

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ダイナマイトビーティーエス

洋楽最新ヒット2020.08.20

ディス・イズ・ミーグレイテスト・ショーマン・キャスト

洋楽人気動画2018.01.11

グッド・ライフGイージー、ケラーニ

洋楽人気動画2017.01.27

ホワット・ドゥ・ユー・ミーン?ジャスティン・ビーバー

洋楽人気動画2015.08.28

ファイト・ソングレイチェル・プラッテン

洋楽人気動画2015.05.19

ラヴ・ミー・ライク・ユー・ドゥエリー・ゴールディング

洋楽人気動画2015.01.22

アップタウン・ファンクブルーノ・マーズ、マーク・ロンソン

洋楽人気動画2014.11.20

ブレイク・フリーアリアナ・グランデ

洋楽人気動画2014.08.12

ハッピーファレル・ウィリアムス

ポップス2014.01.08

カウンティング・スターズワンリパブリック

ロック2013.05.31

ア・サウザンド・イヤーズクリスティーナ・ペリー

洋楽人気動画2011.10.26

ユー・レイズ・ミー・アップケルティック・ウーマン

洋楽人気動画2008.05.30

ルーズ・ユアセルフエミネム

洋楽人気動画2008.02.21

ドント・ノー・ホワイノラ・ジョーンズ

洋楽人気動画2008.02.15

オンリー・タイムエンヤ

洋楽人気動画2007.10.03

ミス・ア・シングエアロスミス

ロック2007.08.18

タイム・トゥ・セイ・グッバイサラ・ブライトマン

洋楽人気動画2007.06.08

シェイプ・オブ・マイ・ハートスティング

洋楽人気動画2007.03.18

ウィ・アー・ザ・ワールド(U.S.A. フォー・アフリカ)マイケル・ジャクソン

洋楽人気動画2006.05.14

ホテル・カリフォルニアイーグルス

ロック2005.07.06