TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - マーク・レイバート: 走って飛び跳ねて、ドアも開けられるロボット犬「スポット」

TED Talks

走って飛び跳ねて、ドアも開けられるロボット犬「スポット」

Meet Spot, the robot dog that can run, hop and open doors

マーク・レイバート

Marc Raibert

内容

ロボットが人間や動物と同じように行動する、そんなサイエンス・フィクションで描かれる未来は意外とすぐそこまで来ているのかもしれません。ボストン・ダイナミクス社を創設したマーク・レイバートが開発している先進的ロボットは、チーターのように駆けたり、深さ25cmの雪の中を進んだり、2足直立歩行したり、さらにはドアを開けて荷物を配達したりできます。レイバートが会場でデモを披露する機敏なロボット「スポットミニ」は、周辺空間をマッピングし、物を取り扱い、階段も上れます。もしかすると、近いうちにロボットが身のまわりのことを手伝ってくれるようになるかもしれません。

字幕

SCRIPT

Script

(Laughter)

(Laughter)

That's SpotMini. He'll be back in a little while.

I --

(Applause)

I love building robots. And my long-term goal is to build robots that can do what people and animals do. And there's three things in particular that we're interested in. One is balance and dynamic mobility, the second one is mobile manipulation, and the third one is mobile perception.

So, dynamic mobility and balance -- I'm going to do a demo for you. I'm standing here, balancing. I can see you're not very impressed. OK, how about now?

(Laughter)

How about now?

(Applause)

Those simple capabilities mean that people can go almost anywhere on earth, on any kind of terrain. We want to capture that for robots.

What about manipulation? I'm holding this clicker in my hand; I'm not even looking at it, and I can manipulate it without any problem. But even more important, I can move my body while I hold the manipulator, the clicker, and stabilize and coordinate my body, and I can even walk around. And that means I can move around in the world and expand the range of my arms and my hands and really be able to handle almost anything. So that's mobile manipulation. And all of you can do this.

Third is perception. I'm looking at a room with over 1,000 people in it, and my amazing visual system can see every one of you -- you're all stable in space, even when I move my head, even when I move around. That kind of mobile perception is really important for robots that are going to move and act out in the world.

I'm going to give you a little status report on where we are in developing robots toward these ends. The first three robots are all dynamically stabilized robots. This one goes back a little over 10 years ago -- "BigDog." It's got a gyroscope that helps stabilize it. It's got sensors and a control computer.

Here's a Cheetah robot that's running with a galloping gait, where it recycles its energy, it bounces on the ground, and it's computing all the time in order to keep itself stabilized and propelled.

And here's a bigger robot that's got such good locomotion using its legs, that it can go in deep snow. This is about 10 inches deep, and it doesn't really have any trouble.

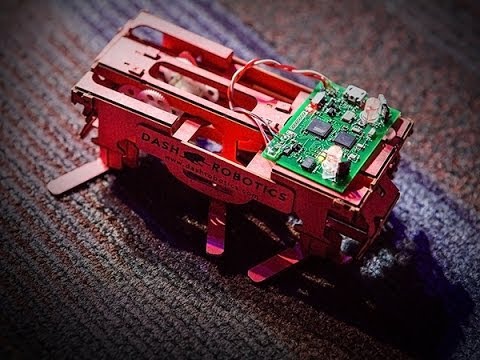

This is Spot, a new generation of robot -- just slightly older than the one that came out onstage. And we've been asking the question -- you've all heard about drone delivery: Can we deliver packages to your houses with drones? Well, what about plain old legged-robot delivery?

(Laughter)

So we've been taking our robot to our employees' homes to see whether we could get in --

(Laughter)

the various access ways. And believe me, in the Boston area, there's every manner of stairway twists and turns. So it's a real challenge. But we're doing very well, about 70 percent of the way.

And here's mobile manipulation, where we've put an arm on the robot, and it's finding its way through the door. Now,one of the important things about making autonomous robots is to make them not do just exactly what you say, but make them deal with the uncertainty of what happens in the real world. So we have Steve there,one of the engineers, giving the robot a hard time.

(Laughter)

And the fact that the programming still tolerates all that disturbance -- it does what it's supposed to.

Here's another example, where Eric is tugging on the robot as it goes up the stairs. And believe me, getting it to do what it's supposed to do in those circumstances is a real challenge, but the result is something that's going to generalize and make robots much more autonomous than they would be otherwise.

This is Atlas, a humanoid robot. It's a third-generation humanoid that we've been building. I'll tell you a little bit about the hardware design later. And we've been saying: How close to human levels of performance and speed could we get in an ordinary task, like moving boxes around on a conveyor? We're getting up to about two-thirds of the speed that a human operates on average. And this robot is using both hands, it's using its body, it's stepping, so it's really an example of dynamic stability, mobile manipulation and mobile perception. Here --

(Laughter)

We actually have two Atlases.

(Laughter)

Now, everything doesn't go exactly the way it's supposed to.

(Laughter)

(Laughter)

(Laughter)

And here's our latest robot, called "Handle." Handle is interesting, because it's sort of half like an animal, and it's half something else with these leg-like things and wheels. It's got its arms on in kind of a funny way, but it really does some remarkable things. It can carry 100 pounds. It's probably going to lift more than that, but so far we've done 100. It's got some pretty good rough-terrain capability, even though it has wheels. And Handle loves to put on a show.

(Laughter)

(Applause)

I'm going to give you a little bit of robot religion. A lot of people think that a robot is a machine where there's a computer that's telling it what to do, and the computer is listening through its sensors. But that's really only half of the story. The real story is that the computer is on one side, making suggestions to the robot, and on the other side are the physics of the world. And that physics involves gravity, friction, bouncing into things. In order to have a successful robot, my religion is that you have to do a holistic design, where you're designing the software, the hardware and the behavior all at one time, and all these parts really intermesh and cooperate with each other. And when you get the perfect design, you get a real harmony between all those parts interacting with each other. So it's half software and half hardware, plus the behavior.

We've done some work lately on the hardware, where we tried to go -- the picture on the left is a conventional design, where you have parts that are all bolted together, conductors, tubes, connectors. And on the right is a more integrated thing; it's supposed to look like an anatomy drawing. Using the miracle of 3-D printing, we're starting to build parts of robots that look a lot more like the anatomy of an animal. So that's an upper-leg part that has hydraulic pathways -- actuators, filters -- all embedded, all printed as one piece, and the whole structure is developed with a knowledge of what the loads and behavior are going to be, which is available from data recorded from robots and simulations and things like that.

So it's a data-driven hardware design. And using processes like that, not only the upper leg but some other things, we've gotten our robots to go from big, behemoth, bulky, slow, bad robots -- that one on the right, weighing almost 400 pounds -- down to the one in the middle which was just in the video, weighs about 190 pounds, just a little bit more than me, and we have a new one, which is working but I'm not going to show it to you yet, on the left, which weighs just 165 pounds, with all the same strength and capabilities. So these things are really getting better very quickly.

So it's time for Spot to come back out, and we're going to demonstrate a little bit of mobility, dexterity and perception. This is Seth Davis, who's my robot wrangler today, and he's giving Spot some general direction by steering it around, but all the coordination of the legs and the sensors is done by the robot's computers on board. The robot can walk with a number of different gaits; it's got a gyro, or a solid-state gyro, an IMU on board. Obviously, it's got a battery, and things like that. One of the cool things about a legged robot is, it's omnidirectional. In addition to going forward, it can go sideways, it can turn in place. And this robot is a little bit of a show-off. It loves to use its dynamic gaits, like running --

(Laughter)

And it's got one more.

(Laughter)

Now if it were really a show-off, it would be hopping on one foot, but, you know.

Now, Spot has a set of cameras here, stereo cameras, and we have a feed up in the center. It's kind of dark out in the audience, but it's going to use those cameras in order to look at the terrain right in front of it, while it goes over these obstacles back here. For this demo, Seth is steering, but the robot's doing all its own terrain planning. This is a terrain map, where the data from the cameras is being developed in real time, showing the red spots, which are where it doesn't want to step, and the green spots are the good places. And here it's treating them like stepping-stones. So it's trying to stay up on the blocks, and it adjusts its stride, and there's a ton of planning that has to go into an operation like that, and it does all that planning in real time, where it adjusts the steps a little bit longer or a little bit shorter.

Now we're going to change it into a different mode, where it's just going to treat the blocks like terrain and decide whether to step up or down as it goes. So this is using dynamic balance and mobile perception, because it has to coordinate what it sees along with how it's moving.

The other thing Spot has is a robot arm. Some of you may see that as a head and a neck, but believe me, it's an arm. Seth is driving it around. He's actually driving the hand and the body is following. So the two are coordinated in the way I was talking about before -- in the way people can do that. In fact,one of the cool things Spot can do we call, "chicken-head mode," and it keeps its head in one place in space, and it moves its body all around. There's a variation of this that's called "twerking" --

(Laughter)

but we're not going to use that today.

(Laughter)

So, Spot: I'm feeling a little thirsty. Could you get me a soda? For this demo, Seth is not doing any driving. We have a LIDAR on the back of the robot, and it's using these props we've put on the stage to localize itself. It's gone over to that location. Now it's using a camera that's in its hand to find the cup, picks it up -- and again, Seth's not driving. We've planned out a path for it to go -- it looked like it was going off the path -- and now Seth's going to take over control again, because I'm a little bit chicken about having it do this by itself. Thank you, Spot.

(Applause)

So, Spot: How do you feel about having just finished your TED performance?

(Laughter)

Me, too!

(Laughter)

Thank you all, and thanks to the team at Boston Dynamics, who did all the hard work behind this.

(Applause)

Helen Walters: Marc, come back in the middle. Thank you so much. Come over here, I have questions.

So, you mentioned the UPS and the package delivery. What are the other applications that you see for your robots?

Marc Raibert: You know, I think that robots that have the capabilities I've been talking about are going to be incredibly useful. About a year ago, I went to Fukushima to see what the situation was there, and there's just a huge need for machines that can go into some of the dirty places and help remediate that.

I think it won't be too long until we have robots like this in our homes, and one of the big needs is to take care of the aging and invalids. I think that it won't be too long till we're using robots to help take care of our parents, or probably more likely, have our children help take care of us. And there's a bunch of other things. I think the sky's the limit. Many of the ideas we haven't thought of yet, and people like you will help us think of new applications.

HW: So what about the dark side? What about the military? Are they interested?

MR: Sure, the military has been a big funder of robotics. I don't think the military is the dark side myself, but I think, as with all advanced technology, it can be used for all kinds of things.

HW: Awesome. Thank you so much.

MR: OK, you're welcome.

Thank you.

(Applause)

(笑)

「スポットミニ」でした のちほど また登場します

私は ―

(拍手)

私はロボットを作るのが大好きです 長年の目標としているのが 人間や動物と同じことができる ロボットを作ることです 私たちが特に関心があるのは 次の3つのことです 1つは バランスと動的機動性 2つ目が 移動中の操作 そして3つ目が 移動中の知覚です

まずは 動的機動性と バランスについて デモをしましょう 今 ここに立って バランスを取っています それがどうしたって感じですね では これならどうですか?

(笑)

これなら?

(拍手)

こうした基本的な能力があるお陰で 人間は 地球上の ほぼどこへでも行けます どんな地形であろうとも これをロボットにさせたいんです

操作はどうでしょう? 今 リモコンを手にしていますが 私はリモコンを見なくても 何の問題もなく 操作できていますね でも もっと大事なのが このリモコンを持ちながら 体を動かせることです 体を安定させて 各部を協調させ 歩き回ったりすることもできます つまり 世界の中を動き回って 自分の腕や手の届く範囲を 広げられるので ほぼ 何でも扱えるということなんです これが移動中の操作です 誰でも できますよね

3つ目が知覚です 今 1千人以上がいるこの会場を 見渡していますが 私の素晴らしい視覚系のお陰で 皆さんを1人1人見ることができます しかも 空間の中で 常に安定して見えます 私が頭を動かしたり 動き回ったりしても そうです こうした 移動中の知覚は ロボットが世の中に出て 動き そして行動するにあたって 非常に重要です

こうした目標に対して ロボット開発が どの段階にあるのか 簡単にご報告しましょう 最初にお見せする3つのロボットは どれも動的安定性を備えています こちらは10年ちょっと前に 開発した ― 「ビックドッグ」です 安定性を得るために 姿勢制御装置を組み込み 複数のセンサーと 制御コンピューターも積んでいます

こちらはチーター型のロボットで 速がけの走り方をします 走りながらエネルギーを再利用し 地面を飛び跳ねます 常時 計算を行っていて 安定性と推進力が 保たれるようになっています

こちらは もっと大きなロボットで 脚を巧みに使って 深い雪の中でも移動できます 25cmほどの積雪でしたが 何の問題もありませんでした

こちらは「スポット」 新しい世代のロボットです さきほどステージでご紹介したロボットより 少し古い型です 私たちがずっと 追い求めてきたこと ― ドローンによる宅配 「ドローンで荷物を配達できるか?」 というのがよく話題になりますが 昔ながらの普通の足付きロボットで 配達するのはどうでしょう?

(笑)

ですから 私たちはロボットを 社員たちの家に連れて行き 自分で中に入れるか試しています

(笑)

玄関アプローチもいろいろですから 実際 ボストン地区では 階段や曲がり角などもあり 多種多様です かなりの挑戦です でも うまくやっていて 7割くらいは成功しています

ここで移動中の操作が出てきます ロボットに 腕を付けているのですが ロボットはドアを通り抜けようと 模索しています 自律型ロボットを作る上で 最も重要なのは 指示された通りのことだけを するのでなく 現実の世界で起こる不確実なことに 自分で対処できるようにするということです ここでは エンジニアのスティーブが ロボットに意地悪しています

(笑)

これだけ邪魔しても プログラムが何とか持ちこたえていて すべきことを ちゃんと こなせています

こちらのケースでは エリックが 階段を上ろうとするロボットを 紐で引き戻しています 本当に こういった状況で ロボットに 計画どおりのことを させるのは かなり大変なんです でも その結果 得られることは ほかのことにも適用でき そうしなかった場合よりも 格段に自律的なロボットができるのです

こちらは人間型ロボット 「アトラス」です 私たちが作っている 人間型ロボットの第3世代です ハードウェアの設計について あとでお話ししますが 私たちが目指してきたのは 一般的な作業における動きとスピードを どれだけ人間のレベルに 近づけられるかです 例えば コンベヤー上の箱を 移すような作業でです 現在 人間の平均作業スピードの 3分の2くらいまでになっています このロボットは両手を使い さらに体も使って 足も動かしています これこそ まさに 動的な安定性 移動中の操作 移動中の知覚を使った例です これは ―

(笑)

実は アトラスは2台あります

(笑)

もちろん すべてが 思いどおりに行くわけではありません

(笑)

(笑)

こちらが最新作のロボットの 「ハンドル」です ハンドルが おもしろいのは 動物と 何か別のものを 足して2で割った感じに なっていることで この車輪のついた 脚のようなものがあり 腕も ちょっと変わった風に 付いています でも 実は素晴らしいことができるんです 45kgの物を運べます おそらく それ以上でも持ち上げられますが 45kgまでしか試していません 起伏の大きい場所も 得意としています 車輪で走るにもかかわらずです それから ハンドルは いい格好しいです

(笑)

(拍手)

ロボット哲学について 少しお話ししましょう 多くの方はこう思われているでしょう ロボットは ただの機械で コンピューターの指示どおりに動き コンピューターはセンサーを通じて 情報を取っているのだと でも それで見えるのは 物事の片面だけです 実際は コンピューターが ロボットに提案をする一方で 実世界の物理法則も 作用しています 物理的なものには 重力や摩擦 他の物との衝突などがあります 良いロボットを作るには 総合的な設計をしなければならない というのが私の信条です つまり ソフトウェア ハードウェアと動作をすべて一緒に 設計するのです そうすることで 各部分が うまくかみ合って協調できます 完ぺきな設計をすると 真の調和が生まれ これらの部分が 互いにうまく作用します つまり それは半分ソフトウェアで 半分ハードウェアであり それに加えて動作があるのです

最近 私たちが目指す方向で ハードウェアを改良しました 左の写真は これまでの設計で いろんな部品が くっつけ合わせられています コンダクターやチューブ コネクターなどです 右側は もっと統合されていて 解剖図のように見えます 3Dプリンティングの魔法を使って 動物の体の構造に ぐっと近づけた形で ロボットを組み立てようと し始めているのです こちらは大腿部で 油圧経路や アクチュエータやフィルターがありますが すべてが組み込まれた 1つの部品として 3D印刷されています 全体の構造を開発するため まずは どんな負荷がかかり どんな動作をするかを ロボットの記録データや シミュレーションなどから 把握しました

つまり データ駆動の ハードウェア設計というわけです 大腿部だけでなく ほかの部分にも そうしたプロセスを使うことで 私たちは 巨大でゴツゴツして とろくて見た目も悪いロボット ― 右にあるような 170kgくらいあるロボットを さっきビデオでもご紹介した 真ん中のロボットにまで小さくしました 重さは90kg弱です 私より ちょっと重いくらいですね そして 新たに開発したのが ― まだお見せできませんが ちゃんと動きます ― 左側のもので たった75kgです これまでと同じパワーと能力も備えています こうした改良は かなり速いスピードで進んでいます

さて 再び スポットの出番です その機動性、器用さと知覚力を ちょっとご覧に入れましょう こちらはセス・デイビス 今日は ロボットの世話をしてくれます 彼は コントローラーで操縦して スポットに おおまかな指示を与えますが センサーデータによる 脚の動きの調整などは すべて ロボットに搭載された コンピューターが行います ロボットは いろんな歩調で 歩くことができ 姿勢制御装置 ― 半導体の姿勢制御装置や IMU(慣性計測装置)を搭載しています もちろん 電池などもあります 脚のあるロボットの特長の1つは 全方位的であることです 前に進むこともできれば 横にも行けますし その場で回転もできます それと このロボット ちょっと自慢屋さんで 動きの大きい歩き方を披露したがります 走ったりね ―

(笑)

こんなのも できますよ

(笑)

1本足で飛び跳ねられたら 本当にすごいんですけど まだね

ここに一組のカメラがあります ステレオ・カメラです ステージ中央に映しているのが その映像です 会場を写していて 少し暗いですが これからスポットが このカメラを使って 目の前にある地面を見ながら 障害物を越えていくのを ご覧に入れます このデモでは セスが操縦していますが どこを歩くかといった計画は ロボットが自ら行います こちらが地形図で カメラからのデータが リアルタイムで展開され 足を踏み入れたくない場所を 赤く表示しています 緑色のところは 安全な場所です 今 ロボットはブロックを 飛び石のようにしています ブロックの上に 上がったままでいようと 歩幅も調整しています こんな動きをさせるには 本当にたくさんの計画が必要ですが それもリアルタイムで やってのけるのです 例えば 歩幅をちょっと長くとか ちょっと短くという具合にです

今度は モードを変えてみます ロボットは ブロックを 地面の起伏として捉えて 進みながら 上がるか降りるか 判断します こんな風に動的にバランスをとり 動きながら知覚を使っています 見えているものに合わせて 動きを調整しなければならないからです

スポットには ロボットアームがあります 頭と首のように 見えるかもしれませんが これは腕(アーム)なんです セスが動かしていますが 実は操作しているのは腕だけで 体の動きは勝手についてきています さきほどお話ししたとおりで その2つが連携しているのです まるで人間のようにです スポットのカッコいい得意技に 「鶏の頭モード」というのがあります 頭の位置を固定して 体だけを ぐるっと動かします これをアレンジしたもので 「尻振りダンス」もできます

(笑)

でも 今日は やめておきます

(笑)

スポット ちょっと喉が渇いたんだけど ソーダを取ってきてくれる? このデモでは セスは一切 操縦していません ロボットの背中には LIDAR(レーザー測距)装置があり ロボットは ステージに置かれた 小道具を頼りに 場所を特定しています 今 その場所まで たどり着きました 手に組み込まれたカメラを使って カップを見つけて 拾い上げます ― もう一度言いますが セスは操縦していません 私たちはロボットが通るべき経路を 計画しました ― 道をそれたようですが さて ここで セスが再び操縦を始めます 自分で手渡させるのは ちょっと心もとないのでね ありがとう スポット

(拍手)

ねえ スポット TEDでのパフォーマンスを終えて どんな気持ちだい?

(笑)

同感だよ

(笑)

皆さん ありがとうございました ボストン・ダイナミクスの皆も ありがとう これまで一生懸命やってくれたお陰です

(拍手)

(ヘレン・ウォルターズ)マーク ありがとうございました どうぞ こちら中央まで 質問があります

さきほどUPSや宅配について お話しされていましたが 開発されたロボットは ほかに どんなことに使えそうですか?

(マーク・レイバート)ロボットは ― 私がご紹介した能力があれば 本当に役に立つと思います 1年ほど前 福島に行って 現場視察をしてきたのですが 汚染された場所に ロボットを送り込んで 修復作業を支援する といったニーズも 非常に大きいんです

各家庭に こんなロボットが登場するのも それほど先ではないでしょう お年寄りや病気の方のお世話をするという 大きなニーズもあります 遠くない将来 私たちはロボットの助けを借りて 両親の介護をすることに なるでしょう というよりむしろ 私たちの介護に 子どもたちがロボットを使うかもしれません ほかにも いろいろできます 可能性は無限大です まだ思いついていないこともあるでしょう 皆さんにも ぜひ 新しい活用法を考えていただきたいです

(ヘレン)負の側面はどうでしょう? 軍事用途とか? ご関心はありますか?

(マーク)ええ 軍はロボット工学に 大きな投資をしてきました ただ 私自身は 軍事が 負の側面とは思いません どんな先進技術でもそうですが 用途は いろいろあるわけです

(ヘレン)ありがとうございました

(マーク)こちらこそ

ありがとうございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

しなやかで柔軟性を持つロボットの驚くべき可能性 - TED Talkジアーダ・ゲルボーニ

2018.07.05

ロボットの気持ちを考える ― 人間とロボットの共存社会を目指してレイラ・タカヤマ

2018.02.16

魚の群れから学習する知能機械ラディカ・ナグパール

2017.10.06

ロボットは大学入試に合格できるか?新井紀子

おすすめ 12017.09.13

汚染物資を「食べる」ロボットジョナサン・ロシター

2017.03.15

魅惑的な未来の飛行ロボットを披露ラファエロ・ダンドリーア

2016.03.11

イモリの様に走り、泳ぐことのできるロボットアウケ・エイスペールト

2016.02.18

空飛ぶロボットの未来ヴィージェイ・クーマー

2015.11.04

米粒のサイズのロボットを作る理由サラ・バーグブライター

2015.01.21

空飛ぶカメラ、ただしリード付きセルゲイ・ルパシン

2014.10.28

自然界で最も不快な生き物にヒントを得たロボットロバート・フル

2014.06.06

「心」を宿したロボットガイ・ホフマン

2014.01.17

私の水中探査ロボットデイビッド・ラング

2013.12.05

なぜ、私たちはロボットに頼ることになるのかロドニー・ブルックス

2013.06.28

クアッドコプターの驚くべき運動能力ラファエロ・ダンドリーア

2013.06.11

あなたの携帯をパーソナル・ロボットに変える発明ケラー・リナウド

2013.04.09

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ステイザ・キッド・ラロイ、ジャスティン・ビーバー

洋楽最新ヒット2021.08.20

スピーチレス~心の声ナオミ・スコット

洋楽最新ヒット2019.05.23

シェイプ・オブ・ユーエド・シーラン

洋楽人気動画2017.01.30

フェイデッドアラン・ウォーカー

洋楽人気動画2015.12.03

ウェイティング・フォー・ラヴアヴィーチー

洋楽人気動画2015.06.26

シー・ユー・アゲインウィズ・カリファ

洋楽人気動画2015.04.06

シュガーマルーン5

洋楽人気動画2015.01.14

シェイク・イット・オフテイラー・スウィフト

ポップス2014.08.18

オール・アバウト・ザット・ベースメーガン・トレイナー

ポップス2014.06.11

ストーリー・オブ・マイ・ライフワン・ダイレクション

洋楽人気動画2013.11.03

コール・ミー・メイビーカーリー・レイ・ジェプセン

洋楽人気動画2012.03.01

美しき生命コールドプレイ

洋楽人気動画2008.08.04

バッド・デイ~ついてない日の応援歌ダニエル・パウター

洋楽人気動画2008.05.14

サウザンド・マイルズヴァネッサ・カールトン

洋楽人気動画2008.02.19

イッツ・マイ・ライフボン・ジョヴィ

ロック2007.10.11

アイ・ウォント・イット・ザット・ウェイバックストリート・ボーイズ

洋楽人気動画2007.09.14

マイ・ハート・ウィル・ゴー・オンセリーヌ・ディオン

洋楽人気動画2007.07.12

ヒーローマライア・キャリー

洋楽人気動画2007.03.21

オールウェイズ・ラヴ・ユーホイットニー・ヒューストン

洋楽人気動画2007.02.19

オネスティビリー・ジョエル

洋楽人気動画2005.09.16