TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - エイブ・デイヴィス: 物の隠れた性質を解き明かす新しい映像技術

TED Talks

物の隠れた性質を解き明かす新しい映像技術

New video technology that reveals an object's hidden properties

エイブ・デイヴィス

Abe Davis

内容

音が物に引き起こす小さな振動をはじめ、私たちの周りでは微細な動きが絶えず起きています。最近の技術は、見たところ動きのない物の映像からそのような振動を拾い出し、音や会話を復元することを可能にしていますが、エイブ・デイヴィスはそれをさらに1歩進めています。何の変哲もないビデオから、物の隠れた性質を対話的に探れるソフトウェアのデモを是非ご覧ください。

字幕

SCRIPT

Script

Most of us think of motion as a very visual thing. If I walk across this stage or gesture with my hands while I speak, that motion is something that you can see. But there's a world of important motion that's too subtle for the human eye, and over the past few years, we've started to find that cameras can often see this motion even when humans can't.

So let me show you what I mean. On the left here, you see video of a person's wrist, and on the right, you see video of a sleeping infant, but if I didn't tell you that these were videos, you might assume that you were looking at two regular images, because in both cases, these videos appear to be almost completely still. But there's actually a lot of subtle motion going on here, and if you were to touch the wrist on the left, you would feel a pulse, and if you were to hold the infant on the right, you would feel the rise and fall of her chest as she took each breath. And these motions carry a lot of significance, but they're usually too subtle for us to see, so instead, we have to observe them through direct contact, through touch.

But a few years ago, my colleagues at MIT developed what they call a motion microscope, which is software that finds these subtle motions in video and amplifies them so that they become large enough for us to see. And so, if we use their software on the left video, it lets us see the pulse in this wrist, and if we were to count that pulse, we could even figure out this person's heart rate. And if we used the same software on the right video, it lets us see each breath that this infant takes, and we can use this as a contact-free way to monitor her breathing.

And so this technology is really powerful because it takes these phenomena that we normally have to experience through touch and it lets us capture them visually and non-invasively.

So a couple years ago, I started working with the folks that created that software, and we decided to pursue a crazy idea. We thought, it's cool that we can use software to visualize tiny motions like this, and you can almost think of it as a way to extend our sense of touch. But what if we could do the same thing with our ability to hear? What if we could use video to capture the vibrations of sound, which are just another kind of motion, and turn everything that we see into a microphone?

Now, this is a bit of a strange idea, so let me try to put it in perspective for you. Traditional microphones work by converting the motion of an internal diaphragm into an electrical signal, and that diaphragm is designed to move readily with sound so that its motion can be recorded and interpreted as audio. But sound causes all objects to vibrate. Those vibrations are just usually too subtle and too fast for us to see.

So what if we record them with a high-speed camera and then use software to extract tiny motions from our high-speed video, and analyze those motions to figure out what sounds created them? This would let us turn visible objects into visual microphones from a distance. And so we tried this out, and here's one of our experiments, where we took this potted plant that you see on the right and we filmed it with a high-speed camera while a nearby loudspeaker played this sound.

(Music: "Mary Had a Little Lamb")

And so here's the video that we recorded, and we recorded it at thousands of frames per second, but even if you look very closely, all you'll see are some leaves that are pretty much just sitting there doing nothing, because our sound only moved those leaves by about a micrometer. That's one ten-thousandth of a centimeter, which spans somewhere between a hundredth and a thousandth of a pixel in this image. So you can squint all you want, but motion that small is pretty much perceptually invisible. But it turns out that something can be perceptually invisible and still be numerically significant, because with the right algorithms, we can take this silent, seemingly still video and we can recover this sound.

(Music: "Mary Had a Little Lamb")

(Applause)

So how is this possible? How can we get so much information out of so little motion? Well, let's say that those leaves move by just a single micrometer, and let's say that that shifts our image by just a thousandth of a pixel. That may not seem like much, but a single frame of video may have hundreds of thousands of pixels in it, and so if we combine all of the tiny motions that we see from across that entire image, then suddenly a thousandth of a pixel can start to add up to something pretty significant.

On a personal note, we were pretty psyched when we figured this out. (Laughter) But even with the right algorithm, we were still missing a pretty important piece of the puzzle. You see, there are a lot of factors that affect when and how well this technique will work. There's the object and how far away it is; there's the camera and the lens that you use; how much light is shining on the object and how loud your sound is. And even with the right algorithm, we had to be very careful with our early experiments, because if we got any of these factors wrong, there was no way to tell what the problem was. We would just get noise back. And so a lot of our early experiments looked like this. And so here I am, and on the bottom left, you can kind of see our high-speed camera, which is pointed at a bag of chips, and the whole thing is lit by these bright lamps. And like I said, we had to be very careful in these early experiments, so this is how it went down.

(Video) Abe Davis: Three,two,one, go. Mary had a little lamb! Little lamb! Little lamb!

(Laughter)

AD: So this experiment looks completely ridiculous. (Laughter) I mean, I'm screaming at a bag of chips -- (Laughter) -- and we're blasting it with so much light, we literally melted the first bag we tried this on. (Laughter) But ridiculous as this experiment looks, it was actually really important, because we were able to recover this sound.

(Audio) Mary had a little lamb! Little lamb! Little lamb!

(Applause)

AD: And this was really significant, because it was the first time we recovered intelligible human speech from silent video of an object. And so it gave us this point of reference, and gradually we could start to modify the experiment, using different objects or moving the object further away, using less light or quieter sounds. And we analyzed all of these experiments until we really understood the limits of our technique, because once we understood those limits, we could figure out how to push them.

And that led to experiments like this one, where again, I'm going to speak to a bag of chips, but this time we've moved our camera about 15 feet away, outside, behind a soundproof window, and the whole thing is lit by only natural sunlight. And so here's the video that we captured. And this is what things sounded like from inside, next to the bag of chips.

(Audio) Mary had a little lamb whose fleece was white as snow, and everywhere that Mary went, that lamb was sure to go.

AD: And here's what we were able to recover from our silent video captured outside behind that window.

(Audio) Mary had a little lamb whose fleece was white as snow, and everywhere that Mary went, that lamb was sure to go.

(Applause)

AD: And there are other ways that we can push these limits as well. So here's a quieter experiment where we filmed some earphones plugged into a laptop computer, and in this case, our goal was to recover the music that was playing on that laptop from just silent video of these two little plastic earphones, and we were able to do this so well that I could even Shazam our results. (Laughter)

(Music: "Under Pressure" by Queen)

(Applause)

And we can also push things by changing the hardware that we use. Because the experiments I've shown you so far were done with a camera, a high-speed camera, that can record video about a 100 times faster than most cell phones, but we've also found a way to use this technique with more regular cameras, and we do that by taking advantage of what's called a rolling shutter. You see, most cameras record images one row at a time, and so if an object moves during the recording of a single image, there's a slight time delay between each row, and this causes slight artifacts that get coded into each frame of a video. And so what we found is that by analyzing these artifacts, we can actually recover sound using a modified version of our algorithm. So here's an experiment we did where we filmed a bag of candy while a nearby loudspeaker played the same "Mary Had a Little Lamb" music from before, but this time, we used just a regular store-bought camera, and so in a second, I'll play for you the sound that we recovered, and it's going to sound distorted this time, but listen and see if you can still recognize the music.

(Audio: "Mary Had a Little Lamb")

And so, again, that sounds distorted, but what's really amazing here is that we were able to do this with something that you could literally run out and pick up at a Best Buy.

So at this point, a lot of people see this work, and they immediately think about surveillance. And to be fair, it's not hard to imagine how you might use this technology to spy on someone. But keep in mind that there's already a lot of very mature technology out there for surveillance. In fact, people have been using lasers to eavesdrop on objects from a distance for decades. But what's really new here, what's really different, is that now we have a way to picture the vibrations of an object, which gives us a new lens through which to look at the world, and we can use that lens to learn not just about forces like sound that cause an object to vibrate, but also about the object itself.

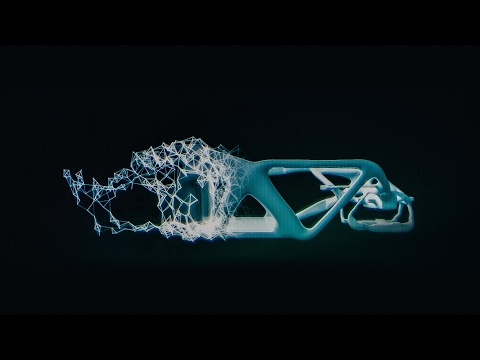

And so I want to take a step back and think about how that might change the ways that we use video, because we usually use video to look at things, and I've just shown you how we can use it to listen to things. But there's another important way that we learn about the world: that's by interacting with it. We push and pull and poke and prod things. We shake things and see what happens. And that's something that video still won't let us do, at least not traditionally. So I want to show you some new work, and this is based on an idea I had just a few months ago, so this is actually the first time I've shown it to a public audience. And the basic idea is that we're going to use the vibrations in a video to capture objects in a way that will let us interact with them and see how they react to us.

So here's an object, and in this case, it's a wire figure in the shape of a human, and we're going to film that object with just a regular camera. So there's nothing special about this camera. In fact, I've actually done this with my cell phone before. But we do want to see the object vibrate, so to make that happen, we're just going to bang a little bit on the surface where it's resting while we record this video.

So that's it: just five seconds of regular video, while we bang on this surface, and we're going to use the vibrations in that video to learn about the structural and material properties of our object, and we're going to use that information to create something new and interactive. And so here's what we've created. And it looks like a regular image, but this isn't an image, and it's not a video, because now I can take my mouse and I can start interacting with the object. And so what you see here is a simulation of how this object would respond to new forces that we've never seen before, and we created it from just five seconds of regular video.

(Applause)

And so this is a really powerful way to look at the world, because it lets us predict how objects will respond to new situations, and you could imagine, for instance, looking at an old bridge and wondering what would happen, how would that bridge hold up if I were to drive my car across it. And that's a question that you probably want to answer before you start driving across that bridge. And of course, there are going to be limitations to this technique, just like there were with the visual microphone, but we found that it works in a lot of situations that you might not expect, especially if you give it longer videos.

So for example, here's a video that I captured of a bush outside of my apartment, and I didn't do anything to this bush, but by capturing a minute-long video, a gentle breeze caused enough vibrations that we could learn enough about this bush to create this simulation. (Applause) And so you could imagine giving this to a film director, and letting him control, say, the strength and direction of wind in a shot after it's been recorded. Or, in this case, we pointed our camera at a hanging curtain, and you can't even see any motion in this video, but by recording a two-minute-long video, natural air currents in this room created enough subtle, imperceptible motions and vibrations that we could learn enough to create this simulation.

And ironically, we're kind of used to having this kind of interactivity when it comes to virtual objects, when it comes to video games and 3D models, but to be able to capture this information from real objects in the real world using just simple, regular video, is something new that has a lot of potential.

So here are the amazing people who worked with me on these projects. (Applause)

And what I've shown you today is only the beginning. We've just started to scratch the surface of what you can do with this kind of imaging, because it gives us a new way to capture our surroundings with common, accessible technology. And so looking to the future, it's going to be really exciting to explore what this can tell us about the world.

Thank you.

(Applause)

私たちはみんな動きというのは 見えるものだと思っています 私がステージの上を歩き 話しながら身振り手振りをする そのような動きは 目に見えるものです しかしあまりに小さくて人の目には留まらない 重要な動きの世界があります この何年か私たちは そういった動きが 人の目には見えなくとも カメラなら捉えられることに 注意を払うようになりました

どういうことか 説明しましょう 左側は人の手の映像で 右側は眠っている 赤ちゃんの映像です しかし もし私が ビデオだと言わなければ 皆さん写真を見ているのだと 思ったことでしょう どちらの映像にも ほとんど動きがないからです それでもここには 沢山の微細な動きがあります 左側の人の 手首に触れてみたなら 脈を感じるだろうし 右側の赤ちゃんを 抱きかかえたなら 呼吸に応じて赤ちゃんの胸が 上下するのを 感じられることでしょう これらの動きは 大切なものですが あまりに小さくて 見ただけでは分からないため 手で直に触って 感じ取る必要があるのです

しかし数年前に MITの同僚が「モーション・マイクロスコープ」 というのを作りました 映像の中の このような小さな動きを 検出して拡大し 目で見て分かるようにする ソフトウェアです そのソフトウェアを 左の映像に使うと 手首の脈動が 目に見えるようになり 脈を数えて 心拍数を測定する ことだってできます そのソフトウェアを 右の映像に使ったなら 赤ちゃんのする呼吸が 目に見えるようになり 触れることなく赤ちゃんの呼吸の状況を モニタできるようになります

これはとても 強力な技術です 通常は触れなければ 分からない現象を 接触せずに視覚だけで 捉えられるからです

2年ほど前から私は このソフトウェアを 考案した人たちと共同で研究するようになり 奇想天外なアイデアに 挑戦することにしました このソフトウェアで 小さな動きを可視化して あたかも触覚が拡張されたかのように できるのはすごいけど これを聴覚にも適用できないだろうか と思ったのです 音による振動というのもまた 一種の動きなのだから それを捉えて目に付くものすべてを マイクに変えてしまうことはできないか?

これはちょっと奇妙な アイデアなので 分かるように 説明しましょう 普通のマイクというのは 中にある振動板の動きを 電気信号に変換する 仕組みになっています 振動板は音に敏感に反応して 動くようにデザインされていて その動きを音として解釈し 記録できるようになっています しかし音はどんな物でも 振動させます ただそういった振動はあまりに小さく速いため 目に見えないだけです

この振動を 高速度カメラで撮影して ソフトウェアで その小さな動きを取り出し 分析することで その振動を作り出したのがどんな音か 知ることはできないだろうか? それができれば 離れたところにあるものを 視覚的なマイクへと変えることができます それで試してみました ご覧頂くのは 行った実験の1つで 右の鉢植えの植物を 高速度カメラで 撮影しながら 近くに置いたスピーカーで こんな音を流しました

(曲 『メリーさんのひつじ』)

これが撮影したビデオで 毎秒数千フレームで 撮っていますが 目をこらしてみても ただ葉っぱが じっとしているようにしか 見えないでしょう 音による葉っぱの動きは 1ミクロン程度だからです 1センチの1万分の1です この映像で1ピクセルの 百分の1から千分の1の間 というところです だからいくら 目をこらしたところで そのような小さな動きは 目では捉えられないのです しかし知覚的には 感知できなくとも 数値的には 有意な変化があり 適切なアルゴリズムを使えば この静止しているようにしか 見えない映像から このような音を 取り出すことができます

(曲 『メリーさんのひつじ』)

(拍手)

どうしてそんなことが 可能なのか? そんな小さな動きからどうやって これほど多くの情報を取り出せるのか? 葉っぱの動きが ちょうど1ミクロンで 映像の中の動きは 千分の1ピクセルだったとしましょう これは わずかなものに 見えますが ビデオの1フレームの中には 何十万というピクセルがあり そういった小さな動きを 映像全体から集めれば 千分の1ピクセルが 積み重なって 十分大きなものになるのです

個人的なことですが このことを発見した時には すごく興奮しましたね (笑) 優れたアルゴリズムはありましたが パズルの重要なピースが まだ欠けていました この手法がうまくいくかに 影響する要因は たくさんあります 対象がどんな物で どれくらい離れているか どんなカメラや レンズを使うか 物に当てる光の強さや 音の大きさはどれくらいか そしてアルゴリズムは 優れているにしても 初期の実験はすごく 慎重にやる必要がありました そういった要因の 何か1つでもまずいと 何が悪かったのかも分からず ただノイズが 出てくるだけだからです ですから初期の実験は このような設定で行ったのです 私が写っています 左下に高速度カメラが 設置されていて ポテトチップの袋に 向けられています そして全体が明るい照明で 照らされています 申し上げたように初期の実験は 非常に慎重を期して進めました これがその様子です

(男性の声) 3 2 1 ハイ (デイヴィスが大声で) メリーさんの ヒツジ ヒツジ ヒツジ

(笑)

ご覧のように 馬鹿みたいに見える実験でした (笑) 私がポテトチップの袋に向かって 大声を張り上げています (笑) おまけにすごく強い照明を 当てていたので 最初のポテトチップの袋は 熱で文字通り溶けてしまいました (笑) しかし いかに馬鹿みたいに 見えようとも この実験はとても 重要なものでした このような音を取り出すことに 成功したからです

Mary had a little lamb! Little lamb! Little lamb!

(拍手)

とても重要な瞬間でした 物を撮した 音声のない映像から 聞き取れる人の声を 初めて復元できたからです この実験を基準点として 私たちはいろいろ変化をつけた 実験を始めました 異なる物を使う 物をもっと離れたところに置く 光を弱くする 音を小さくする そういった実験の結果を 分析して この手法の限界を 見極めました ひとたび限界が分かれば どう押し広げられるかも 分かるからです

そうやってこんな実験に たどり着きました ここでもポテトチップの袋に向けて 音を流しますが 今回はカメラが 5メートル離れていて 防音ガラスの 背後にあります 照らしている光も 自然の太陽光です ご覧いただいているのが 撮影した映像です そしてこれが部屋の中で ポテトチップの袋の横で流していた音です

Mary had a little lamb whose fleece was white as snow, (メリーさんは小さな羊を飼っていた 雪のように白い毛をして) and everywhere that Mary went, that lamb was sure to go. (メリーさんの行くところは どこにでも付いてきた)

そしてこれが 窓の背後から撮した 無音の映像から 取り出した音声です

Mary had a little lamb whose fleece was white as snow, and everywhere that Mary went, that lamb was sure to go.

(拍手)

限界を押し広げる方法は 他にもあります こちらはもっと静かな実験で ノートPCに繋いだ イヤホンを撮しています この時の目標は 2つの小さなプラスチック製イヤホンを撮した 無音の映像から かけている曲を復元する ということでした これはすごく うまくいって 結果から曲名を Shazamで当てることさえできました (笑)

(曲 クイーン 『アンダー・プレッシャー』)

(拍手)

使用するハードウェアという点でも 限界を押し広げることができます ここまで ご覧頂いた実験は どれも高速度カメラを使っていて これは通常携帯についている カメラよりも 100倍高速に 撮影することができます しかし私たちは 普通のカメラで この手法を使う方法も 見つけました ローリングシャッターと呼ばれる技術を 利用しています 多くのカメラは 画像を1行ずつ記録しています 1枚の画像の記録中に 撮影対象が動くと 各行に時間的な ズレがあるため ビデオの各フレームに 小さなゆがみが 記録されることになります このゆがみを分析したところ アルゴリズムを改良すれば そこから音を復元できることが分かりました これが行った実験で キャンディの袋を撮し 横では同じ『メリーさんのひつじ』を スピーカーで流していますが 今回は お店で買える 普通のカメラを使っています これから取り出した音を お聞かせします 音にひずみがありますが それでも何の曲か おわかりになると思います

(曲 『メリーさんのひつじ』)

音にひずみがあるにしても これが意味深いのは 家電量販店で買える 普通のカメラで このようなことが できたということです

ここまで ご覧頂いたことから 多くの人が思い浮かべるのは スパイ活動でしょう 確かに誰かをスパイするために この技術を使うというのは 容易に想像できることですが 考えてほしいのは スパイ活動に関しては多くの成熟した技術が すでに存在する ということです 実際 盗聴のために 遠くから物に レーザーを照射するというのは 何十年も前から 行われています 私たちの技術が 本当に新しく 違っている点は 物の振動を見る方法を 手に入れたということで これは世界を見る 新しいレンズになります このレンズを使うと 物を振動させる音のような力について 学べるだけでなく 物自体についても 学ぶことができます

ここで視野を広げて これが私たちのビデオの使い方を いかに変えうるかを考えてみましょう 通常私たちは物を見るために ビデオを使います それから音を聞くためにも 使えることを お見せしました しかし私たちが世界について学ぶ重要な方法が もう1つあります 働きかけることによってです 押したり 引いたり つついたり 揺すったりして 何が起きるか見るのです これはビデオでは できないことです 少なくとも 普通のビデオでは これからお見せするのは 最新の研究で ほんの2、3ヶ月前に思いついた アイデアを元にしています 公の場で見せるのは これが初めてです 基本的なアイデアは 映像の中の振動をヒントに 物の性質を取り出して 働きかけて反応を見られるような 形にするということです

これが対象とする物で 人の形をした 針金人形です これを普通のカメラで ビデオ撮影します カメラに特別なものは 使いません 実際 以前は私の携帯電話を 使っていました 振動する様子を 見たいので 撮影中に 人形が置かれている 台の上を ちょっと叩いてやります

これだけです 5秒間の普通のビデオで 台を叩いています この映像の中の 振動を使って 物の構造的・物質的な性質について 学ぼうというのです そしてその情報を使って 新たなインタラクティブな物を作ります そうしてできたものが これです 何の変哲もない 画像に見えますが これは画像ではなく ビデオでもありません この人形はマウスを使って いじってやることが できるんです ご覧頂いているのは 目にしたことのない 新しい働きかけに対して 物がどう反応するかいう シミュレーションです これをたった5秒間の 普通のビデオから作ったんです

(拍手)

これは世界を見る 新しい強力な方法です 新たな状況に対して 物がどう反応するかを 予測することが できるからです たとえば古い橋を前にして 車で渡っても大丈夫か 分かりかねているという状況を 想像できるでしょう この質問の答えは 橋を渡り始める前に 知りたいはずです もちろんこの手法にも 限界はあり その点は視覚的マイクロフォンと 同じです しかしこの方法は 予想以上に 多くの状況で使え 長いビデオがある場合には 特にそうです

たとえばこれは 私のアパートの前の 藪を撮したビデオで 私は藪に対して 何もしていません しかし1分間 撮している間に やさしいそよ風が この藪について学ぶのに 十分な振動を生み出してくれ このようなシミュレーションを 作れました (拍手) この技術を手にした 映画監督は 映像が撮影された後に 風の強さや向きを変えるのに 使うかもしれません こちらでは吊された カーテンを撮していて 動きは見られませんが 2分のビデオがあれば 室内の自然な空気の 対流で生じた 気付かないような 微かな動きや振動から シミュレーションを作るのに 十分な情報が得られます

このようなインタラクティブなものは ビデオゲームや3Dモデルの中の 架空の物として 見慣れていると思いますが 現実の世界の実際の物から 普通のビデオ映像を使って このような情報を 引き出すというのは 新しいことであり 大きな可能性があります

このプロジェクトに一緒に取り組んでいる 素晴らしい仲間たちです (拍手)

今日お見せしたものは 始まりにすぎません 私たちはこのような映像技術で 可能になることの ほんの表面に 触れたに過ぎません この技術は 誰でも 手に入れられる道具だけで 周りの世界の違った見方を 可能にしてくれるからです この先 この技術が 世界について教えてくれることを 探求していくのは 本当に心躍ることだと 思います

ありがとうございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

10分で分かる量子コンピュータショヒーニ・ゴーシュ

2019.02.01

あなたの人生にサウンドトラックを付けてくれるAIピエール・バロー

2018.10.01

実在の人物の偽映像の作り方と、その見分け方スパソーン・スワジャナコーン

おすすめ 12018.07.25

AIはいかに人の記憶、仕事、社会生活を改善するかトム・グルーバー

2017.08.21

コンピューターはいかに物体を即座に認識できるようになったのかジョセフ・レドモン

2017.08.18

知性を持つ機械を恐れるな、協働せよガルリ・カスパロフ

2017.06.20

人工知能が人間を超えるのを怖れることはないグラディ・ブーチ

2017.03.13

直感を持った人工知能が生み出すすごい発明モーリス・コンティ

2017.02.28

表計算ソフト誕生の話ダン・ブリックリン

2017.02.01

機械知能は人間の道徳性をより重要なものにするゼイナップ・トゥフェックチー

2016.11.11

コンピューターはこうしてクリエイティブになるブレイス・アグエラ・ヤルカス

2016.07.22

Linuxの背後にある精神リーナス・トーバルズ

2016.05.03

ホログラム時代の未来にあるものアレックス・キップマン

2016.04.18

拡張現実ヘッドセットを通して未来を覗くメロン・グリベッツ

2016.04.11

形状変化テクノロジーが仕事を革新するショーン・フォルマー

2016.03.01

インターネットをスクリーンなしで見るとトム・アグロ―

2015.11.13

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ダイナマイトビーティーエス

洋楽最新ヒット2020.08.20

ディス・イズ・ミーグレイテスト・ショーマン・キャスト

洋楽人気動画2018.01.11

グッド・ライフGイージー、ケラーニ

洋楽人気動画2017.01.27

ホワット・ドゥ・ユー・ミーン?ジャスティン・ビーバー

洋楽人気動画2015.08.28

ファイト・ソングレイチェル・プラッテン

洋楽人気動画2015.05.19

ラヴ・ミー・ライク・ユー・ドゥエリー・ゴールディング

洋楽人気動画2015.01.22

アップタウン・ファンクブルーノ・マーズ、マーク・ロンソン

洋楽人気動画2014.11.20

ブレイク・フリーアリアナ・グランデ

洋楽人気動画2014.08.12

ハッピーファレル・ウィリアムス

ポップス2014.01.08

カウンティング・スターズワンリパブリック

ロック2013.05.31

ア・サウザンド・イヤーズクリスティーナ・ペリー

洋楽人気動画2011.10.26

ユー・レイズ・ミー・アップケルティック・ウーマン

洋楽人気動画2008.05.30

ルーズ・ユアセルフエミネム

洋楽人気動画2008.02.21

ドント・ノー・ホワイノラ・ジョーンズ

洋楽人気動画2008.02.15

オンリー・タイムエンヤ

洋楽人気動画2007.10.03

ミス・ア・シングエアロスミス

ロック2007.08.18

タイム・トゥ・セイ・グッバイサラ・ブライトマン

洋楽人気動画2007.06.08

シェイプ・オブ・マイ・ハートスティング

洋楽人気動画2007.03.18

ウィ・アー・ザ・ワールド(U.S.A. フォー・アフリカ)マイケル・ジャクソン

洋楽人気動画2006.05.14

ホテル・カリフォルニアイーグルス

ロック2005.07.06