TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - タン・レイ: 脳波を読むヘッドセット

TED Talks

脳波を読むヘッドセット

A headset that reads your brainwaves

タン・レイ

Tan Le

内容

タン・レイのびっくりするような新しいコンピュータインタフェースは、ユーザの脳波を読み取り、仮想的なオブジェクトや実際の家電機器を念じるだけで(それと少しばかりの集中によって)操作することができます。タン・レイがこのヘッドセットのデモを披露し、いろいろな応用例を紹介します。

字幕

SCRIPT

Script

Up until now, our communication with machines has always been limited to conscious and direct forms. Whether it's something simple like turning on the lights with a switch, or even as complex as programming robotics, we have always had to give a command to a machine, or even a series of commands, in order for it to do something for us. Communication between people, on the other hand, is far more complex and a lot more interesting because we take into account so much more than what is explicitly expressed. We observe facial expressions, body language, and we can intuit feelings and emotions from our dialogue with one another. This actually forms a large part of our decision-making process. Our vision is to introduce this whole new realm of human interaction into human-computer interaction so that computers can understand not only what you direct it to do, but it can also respond to your facial expressions and emotional experiences. And what better way to do this than by interpreting the signals naturally produced by our brain, our center for control and experience.

Well, it sounds like a pretty good idea, but this task, as Bruno mentioned, isn't an easy one for two main reasons: First, the detection algorithms. Our brain is made up of billions of active neurons, around 170,000 km of combined axon length. When these neurons interact, the chemical reaction emits an electrical impulse, which can be measured. The majority of our functional brain is distributed over the outer surface layer of the brain, and to increase the area that's available for mental capacity, the brain surface is highly folded. Now this cortical folding presents a significant challenge for interpreting surface electrical impulses. Each individual's cortex is folded differently, very much like a fingerprint. So even though a signal may come from the same functional part of the brain, by the time the structure has been folded, its physical location is very different between individuals, even identical twins. There is no longer any consistency in the surface signals.

Our breakthrough was to create an algorithm that unfolds the cortex, so that we can map the signals closer to its source, and therefore making it capable of working across a mass population. The second challenge is the actual device for observing brainwaves. EEG measurements typically involve a hairnet with an array of sensors, like the one that you can see here in the photo. A technician will put the electrodes onto the scalp using a conductive gel or paste and usually after a procedure of preparing the scalp by light abrasion. Now this is quite time consuming and isn't the most comfortable process. And on top of that, these systems actually cost in the tens of thousands of dollars.

So with that, I'd like to invite onstage Evan Grant, who is one of last year's speakers, who's kindly agreed to help me to demonstrate what we've been able to develop.

(Applause)

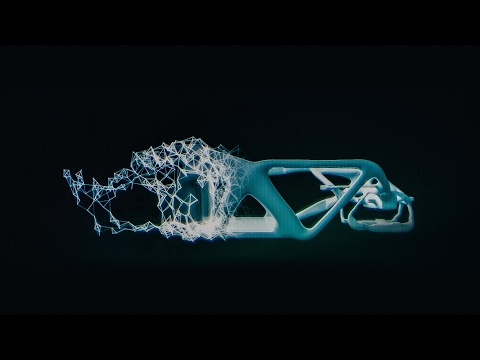

So the device that you see is a 14-channel, high-fidelity EEG acquisition system. It doesn't require any scalp preparation, no conductive gel or paste. It only takes a few minutes to put on and for the signals to settle. It's also wireless, so it gives you the freedom to move around. And compared to the tens of thousands of dollars for a traditional EEG system, this headset only costs a few hundred dollars. Now on to the detection algorithms. So facial expressions -- as I mentioned before in emotional experiences -- are actually designed to work out of the box with some sensitivity adjustments available for personalization. But with the limited time we have available, I'd like to show you the cognitive suite, which is the ability for you to basically move virtual objects with your mind.

Now, Evan is new to this system, so what we have to do first is create a new profile for him. He's obviously not Joanne -- so we'll "add user." Evan. Okay. So the first thing we need to do with the cognitive suite is to start with training a neutral signal. With neutral, there's nothing in particular that Evan needs to do. He just hangs out. He's relaxed. And the idea is to establish a baseline or normal state for his brain, because every brain is different. It takes eight seconds to do this, and now that that's done, we can choose a movement-based action. So Evan, choose something that you can visualize clearly in your mind.

Tan Le: Okay, so let's choose "pull." So the idea here now is that Evan needs to imagine the object coming forward into the screen, and there's a progress bar that will scroll across the screen while he's doing that. The first time, nothing will happen, because the system has no idea how he thinks about "pull." But maintain that thought for the entire duration of the eight seconds. So: one,two,three, go. Okay. So once we accept this, the cube is live. So let's see if Evan can actually try and imagine pulling. Ah, good job!

(Applause) That's really amazing. (Applause)

So we have a little bit of time available, so I'm going to ask Evan to do a really difficult task. And this one is difficult because it's all about being able to visualize something that doesn't exist in our physical world. This is "disappear." So what you want to do -- at least with movement-based actions, we do that all the time, so you can visualize it. But with "disappear," there's really no analogies -- so Evan, what you want to do here is to imagine the cube slowly fading out, okay. Same sort of drill. So: one,two,three, go. Okay. Let's try that. Oh, my goodness. He's just too good. Let's try that again.

EG: Losing concentration.

(Laughter)

TL: But we can see that it actually works, even though you can only hold it for a little bit of time. As I said, it's a very difficult process to imagine this. And the great thing about it is that we've only given the software one instance of how he thinks about "disappear." As there is a machine learning algorithm in this --

(Applause)

Thank you. Good job. Good job.

(Applause)

Thank you, Evan, you're a wonderful, wonderful example of the technology.

So, as you can see, before, there is a leveling system built into this software so that as Evan, or any user, becomes more familiar with the system, they can continue to add more and more detections, so that the system begins to differentiate between different distinct thoughts. And once you've trained up the detections, these thoughts can be assigned or mapped to any computing platform, application or device.

So I'd like to show you a few examples, because there are many possible applications for this new interface. In games and virtual worlds, for example, your facial expressions can naturally and intuitively be used to control an avatar or virtual character. Obviously, you can experience the fantasy of magic and control the world with your mind. And also, colors, lighting, sound and effects can dynamically respond to your emotional state to heighten the experience that you're having, in real time. And moving on to some applications developed by developers and researchers around the world, with robots and simple machines, for example -- in this case, flying a toy helicopter simply by thinking "lift" with your mind.

The technology can also be applied to real world applications -- in this example, a smart home. You know, from the user interface of the control system to opening curtains or closing curtains. And of course, also to the lighting -- turning them on or off. And finally, to real life-changing applications, such as being able to control an electric wheelchair. In this example, facial expressions are mapped to the movement commands.

Man: Now blink right to go right. Now blink left to turn back left. Now smile to go straight.

TL: We really -- Thank you.

(Applause)

We are really only scratching the surface of what is possible today, and with the community's input, and also with the involvement of developers and researchers from around the world, we hope that you can help us to shape where the technology goes from here. Thank you so much.

これまでの私達の 機械に対する コミュニケーションは 意識的で 直接的なものに 限られていました スイッチで電灯を点けるという 単純なことから ロボティクスのプログラミングのような複雑なものまで 機械に何かをさせようと思ったら はっきりと命じたり 一連のコマンドを与える必要がありました 一方で 人と人のコミュニケーションは ずっと複雑で ずっと興味深いものです 明示的には示されない 多くのことが考慮されるからです 表情やボディランゲージを読むことで 会話しながら気持ちや感情を 直感的につかみ取ることができます 実際これは私達の意志決定において 大きな部分を占めています 私達がビジョンに掲げているのは 人とコンピュータの対話の中に 今までにはなかった 人の対話の要素を導入することで コンピュータが 直接命令されたことだけでなく 人の表情や 感情にも 反応できるようにすることです そのための方法として 私達の制御や体験の中心にある 脳が作り出す信号を解釈するより 良い方法はないでしょう

これはとても良いアイデアに見えますが ブルーノも紹介してくれたように 2つの理由により 容易なことではないのです 第一の問題は 検出アルゴリズムです 私達の脳には 活動状態のニューロンが何十億もあり 軸索を繋ぎ合わせると 17万キロにも及びます これらのニューロンが情報を伝えるとき 化学反応が起こす電気信号を 計測することができます 脳の機能部位の 大部分は 脳の表層部分にあります そして知的能力に使える領域を増やすために 脳の表面には たくさんの皺があります この皮質にある皺のために 脳表層の電気信号の解釈は 難しい問題となっています 皮質の皺の入り方は 指紋のように 個人ごとに 異なっているのです だから信号が 脳の同じ機能部位から来ているにしても この皺になった構造のために 物理的な位置が 個人ごとに大きく異なり たとえ一卵性双生児でも 同じにはなりません 表層の信号に 一貫した解釈はできないのです

私達は この問題の解決のため 皮質の皺を展開するアルゴリズムを作りました それによって信号を その発生元に 対応づけることが可能になり 多くの人に適用できるようになったのです もう1つの難問は 脳波を観察するための装置です 脳波測定には通常 センサが並んだヘアネットのようなものを使います 写真でご覧頂いているようなものです その電極を 技師が伝導性の ジェルやペーストを使って 頭皮に取り付けるのですが これをやると あとで軽い 擦り傷のようになります これはとても時間がかかりますし あまり快適なものでもありません その上 こういったシステムは 何万ドルもするのです

ここで去年の講演者であるエヴァン グラントに 登場してもらいましょう 彼は快く 私達の発明のデモへの協力を 引き受けてくださいました

(拍手)

ご覧頂いている装置は 14チャネル 高忠実度 脳波捕捉システムです 頭皮にジェルやペーストを 付ける必要はありません 装着して信号が安定するまで ほんの数分しかかかりません ワイヤレスですので 自由に動き回れます 何万ドルもする従来の 脳波捕捉システムに対し このヘッドセットは ほんの数百ドルしかしません 検出アルゴリズムについてお話ししましょう 前に感情表現としての 表情の話をしましたが 個人に合わせた簡単な 感度調整だけで すぐに表情の捕捉ができるようになります 今日は時間が限られていますので 認知セットだけを ご紹介します これは心の中で 仮想的な物体を動かすというものです

エヴァンは 初めて このシステムを使うので 最初に新しいプロフィールを作ります 彼がジョアンなわけありませんね 「ユーザの追加」で エヴァンと入れます 認知セットを行うにあたって まずニュートラルな状態の信号による トレーニングから始めます ニュートラルというのは 何もしない状態ということです ただくつろいで リラックスします これによって ベースラインというか 脳の標準的な状態を設定します 脳は人によって異なるからです これには8秒かかります それが済んだら ものを動かす課題をどれか選びます ではエヴァン 心の中で明確に イメージできるものを選んでください

「引く」をやってみます

では「引く」を選択します エヴァンには 物体が画面の 手前の方にやってくるところを イメージしてもらいます その間プログレスバーが 伸びていきます 最初は何も起きません 彼が「引く」をどう考えるのか システムはまだ知らないからです 8秒間「引く」ことを イメージし続けてください それでは 1、2、3、はい いいでしょう これを登録してやると 立方体を動かせるようになります ではエヴァンに 「引く」ことをイメージしてもらいましょう わぁ すごい!

(拍手) びっくりしました (拍手)

まだ少し時間があるようですので エヴァンにすごく難しい課題に 挑戦してもらいましょう これが難しいのは 実際の世界には存在しないことを イメージする必要があるためです 「消す」をやります 移動に関するアクションであれば いつもやっている事なので 容易にイメージできます でも「消す」というのは経験がありません ではエヴァン 立方体がゆっくりと 消えていくところをイメージしてください まずは練習です 1、2、3、はい じゃあ試してみましょう ほら! 彼は本当に優秀です もう一度やってみて…

集中力が切れちゃったな

(笑)

でも一度うまくいったの分かりますよね あまり長くは 保てませんでしたけど さっきも言ったように これはイメージするのが とても難しいんです これのいいところは 「消す」をどう考えるか ソフトウェアに いっぺん教えればいいということです この中には機械学習アルゴリズムが入っていて…

(歓声)

どうもありがとう すごい すごい

(拍手)

本当にありがとう エヴァン おかげで素晴しいデモができました

ご覧頂いたように このソフトには計測システムがあって ユーザがシステムに 馴染んでいくのに応じて 機能を追加していくことができるんです そうやってシステムが いろいろ異なる考えを 識別できるようになります 一通り検出のトレーニングが済んだら それぞれの考えを コンピュータや アプリケーションや 装置に 割り当てることができます

いくつか例をお見せしましょう この新しいインタフェースに どれほど多くの応用があるか たとえばゲームや仮想空間では 普通に表情を直感的に使って アバターや 仮想のキャラクタを 操作することができます もちろん魔法のファンタジーを体験し 心で世界をコントロールすることだってできます それからまた 色や 光や 音や 特殊効果も 感情の状態に応じて変化させ リアルタイムで体験を増幅することができます 世界中の研究者や開発者によって ロボットや機械を使った応用例が 開発されています たとえば ここではオモチャのヘリコプターを 飛べと念じるだけで飛ばしています

このテクノロジーは実用的なことにも 応用することができます たとえばスマートホームです 制御システムのユーザインタフェースを通して カーテンを開けたり 閉めたりできます それにもちろん照明を 点けたり 消したりもできます 最後に 本当に人の生活を変える応用です 電動車椅子のコントロールができるんです この例では 表情を移動コマンドに対応づけています

右目のウィンクで右に曲がります 左目のウィンクで左に曲がります 笑顔で直進します

ここでは…ありがとうございます

(拍手)

現在可能なことのほんの一部をご紹介しました コミュニティからの意見や 世界中の開発者や研究者の参加によって このテクノロジーがこれからどこへ向かうべきか 見極めるのに力を貸していただけたらと思います どうもありがとうございました

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

10分で分かる量子コンピュータショヒーニ・ゴーシュ

2019.02.01

あなたの人生にサウンドトラックを付けてくれるAIピエール・バロー

2018.10.01

実在の人物の偽映像の作り方と、その見分け方スパソーン・スワジャナコーン

おすすめ 12018.07.25

AIはいかに人の記憶、仕事、社会生活を改善するかトム・グルーバー

2017.08.21

コンピューターはいかに物体を即座に認識できるようになったのかジョセフ・レドモン

2017.08.18

知性を持つ機械を恐れるな、協働せよガルリ・カスパロフ

2017.06.20

人工知能が人間を超えるのを怖れることはないグラディ・ブーチ

2017.03.13

直感を持った人工知能が生み出すすごい発明モーリス・コンティ

2017.02.28

表計算ソフト誕生の話ダン・ブリックリン

2017.02.01

機械知能は人間の道徳性をより重要なものにするゼイナップ・トゥフェックチー

2016.11.11

コンピューターはこうしてクリエイティブになるブレイス・アグエラ・ヤルカス

2016.07.22

Linuxの背後にある精神リーナス・トーバルズ

2016.05.03

ホログラム時代の未来にあるものアレックス・キップマン

2016.04.18

拡張現実ヘッドセットを通して未来を覗くメロン・グリベッツ

2016.04.11

形状変化テクノロジーが仕事を革新するショーン・フォルマー

2016.03.01

インターネットをスクリーンなしで見るとトム・アグロ―

2015.11.13

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ダイナマイトビーティーエス

洋楽最新ヒット2020.08.20

ディス・イズ・ミーグレイテスト・ショーマン・キャスト

洋楽人気動画2018.01.11

グッド・ライフGイージー、ケラーニ

洋楽人気動画2017.01.27

ホワット・ドゥ・ユー・ミーン?ジャスティン・ビーバー

洋楽人気動画2015.08.28

ファイト・ソングレイチェル・プラッテン

洋楽人気動画2015.05.19

ラヴ・ミー・ライク・ユー・ドゥエリー・ゴールディング

洋楽人気動画2015.01.22

アップタウン・ファンクブルーノ・マーズ、マーク・ロンソン

洋楽人気動画2014.11.20

ブレイク・フリーアリアナ・グランデ

洋楽人気動画2014.08.12

ハッピーファレル・ウィリアムス

ポップス2014.01.08

カウンティング・スターズワンリパブリック

ロック2013.05.31

ア・サウザンド・イヤーズクリスティーナ・ペリー

洋楽人気動画2011.10.26

ユー・レイズ・ミー・アップケルティック・ウーマン

洋楽人気動画2008.05.30

ルーズ・ユアセルフエミネム

洋楽人気動画2008.02.21

ドント・ノー・ホワイノラ・ジョーンズ

洋楽人気動画2008.02.15

オンリー・タイムエンヤ

洋楽人気動画2007.10.03

ミス・ア・シングエアロスミス

ロック2007.08.18

タイム・トゥ・セイ・グッバイサラ・ブライトマン

洋楽人気動画2007.06.08

シェイプ・オブ・マイ・ハートスティング

洋楽人気動画2007.03.18

ウィ・アー・ザ・ワールド(U.S.A. フォー・アフリカ)マイケル・ジャクソン

洋楽人気動画2006.05.14

ホテル・カリフォルニアイーグルス

ロック2005.07.06