TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - ジェレミー・ハワード: 自ら学習するコンピュータの素晴らしくも物恐ろしい可能性

TED Talks

自ら学習するコンピュータの素晴らしくも物恐ろしい可能性

The wonderful and terrifying implications of computers that can learn

ジェレミー・ハワード

Jeremy Howard

内容

コンピューターに学び方を教えた時何が起きるのでしょう?科学技術者であるジェレミー・ハワードが、急速に発展しているディープ・ラーニングの分野で起きている驚くべきことを紹介してくれます。コンピューターが中国語を学び、写真に写っている物を認識し、医療診断をする。(あるディープ・ラーニング・プログラムは何時間ものYouTubeビデオを見た後、「猫」の概念を自ら学び取りました。)この分野の最新動向を押さえておくことにしましょう。それは私達の身の回りのコンピューターの振る舞いを変えることになるでしょうから・・・あなたが思っているよりも早く。

字幕

SCRIPT

Script

It used to be that if you wanted to get a computer to do something new, you would have to program it. Now, programming, for those of you here that haven't done it yourself, requires laying out in excruciating detail every single step that you want the computer to do in order to achieve your goal. Now, if you want to do something that you don't know how to do yourself, then this is going to be a great challenge.

So this was the challenge faced by this man, Arthur Samuel. In 1956, he wanted to get this computer to be able to beat him at checkers. How can you write a program, lay out in excruciating detail, how to be better than you at checkers? So he came up with an idea: he had the computer play against itself thousands of times and learn how to play checkers. And indeed it worked, and in fact, by 1962, this computer had beaten the Connecticut state champion.

So Arthur Samuel was the father of machine learning, and I have a great debt to him, because I am a machine learning practitioner. I was the president of Kaggle, a community of over 200,000 machine learning practictioners. Kaggle puts up competitions to try and get them to solve previously unsolved problems, and it's been successful hundreds of times. So from this vantage point, I was able to find out a lot about what machine learning can do in the past, can do today, and what it could do in the future. Perhaps the first big success of machine learning commercially was Google. Google showed that it is possible to find information by using a computer algorithm, and this algorithm is based on machine learning. Since that time, there have been many commercial successes of machine learning. Companies like Amazon and Netflix use machine learning to suggest products that you might like to buy, movies that you might like to watch. Sometimes, it's almost creepy. Companies like LinkedIn and Facebook sometimes will tell you about who your friends might be and you have no idea how it did it, and this is because it's using the power of machine learning. These are algorithms that have learned how to do this from data rather than being programmed by hand.

This is also how IBM was successful in getting Watson to beat the two world champions at "Jeopardy," answering incredibly subtle and complex questions like this one. [ "The ancient 'Lion of Nimrud' went missing from this city's national museum in 2003 (along with a lot of other stuff)" ] This is also why we are now able to see the first self-driving cars. If you want to be able to tell the difference between, say, a tree and a pedestrian, well, that's pretty important. We don't know how to write those programs by hand, but with machine learning, this is now possible. And in fact, this car has driven over a million miles without any accidents on regular roads.

So we now know that computers can learn, and computers can learn to do things that we actually sometimes don't know how to do ourselves, or maybe can do them better than us. One of the most amazing examples I've seen of machine learning happened on a project that I ran at Kaggle where a team run by a guy called Geoffrey Hinton from the University of Toronto won a competition for automatic drug discovery. Now, what was extraordinary here is not just that they beat all of the algorithms developed by Merck or the international academic community, but nobody on the team had any background in chemistry or biology or life sciences, and they did it in two weeks. How did they do this? They used an extraordinary algorithm called deep learning. So important was this that in fact the success was covered in The New York Times in a front page article a few weeks later. This is Geoffrey Hinton here on the left-hand side. Deep learning is an algorithm inspired by how the human brain works, and as a result it's an algorithm which has no theoretical limitations on what it can do. The more data you give it and the more computation time you give it, the better it gets.

The New York Times also showed in this article another extraordinary result of deep learning which I'm going to show you now. It shows that computers can listen and understand.

(Video) Richard Rashid: Now, the last step that I want to be able to take in this process is to actually speak to you in Chinese. Now the key thing there is, we've been able to take a large amount of information from many Chinese speakers and produce a text-to-speech system that takes Chinese text and converts it into Chinese language, and then we've taken an hour or so of my own voice and we've used that to modulate the standard text-to-speech system so that it would sound like me. Again, the result's not perfect. There are in fact quite a few errors. (In Chinese) (Applause) There's much work to be done in this area. (In Chinese) (Applause)

Jeremy Howard: Well, that was at a machine learning conference in China. It's not often, actually, at academic conferences that you do hear spontaneous applause, although of course sometimes at TEDx conferences, feel free. Everything you saw there was happening with deep learning. (Applause) Thank you. The transcription in English was deep learning. The translation to Chinese and the text in the top right, deep learning, and the construction of the voice was deep learning as well.

So deep learning is this extraordinary thing. It's a single algorithm that can seem to do almost anything, and I discovered that a year earlier, it had also learned to see. In this obscure competition from Germany called the German Traffic Sign Recognition Benchmark, deep learning had learned to recognize traffic signs like this one. Not only could it recognize the traffic signs better than any other algorithm, the leaderboard actually showed it was better than people, about twice as good as people. So by 2011, we had the first example of computers that can see better than people. Since that time, a lot has happened. In 2012, Google announced that they had a deep learning algorithm watch YouTube videos and crunched the data on 16,000 computers for a month, and the computer independently learned about concepts such as people and cats just by watching the videos. This is much like the way that humans learn. Humans don't learn by being told what they see, but by learning for themselves what these things are. Also in 2012, Geoffrey Hinton, who we saw earlier, won the very popular ImageNet competition, looking to try to figure out from one and a half million images what they're pictures of. As of 2014, we're now down to a six percent error rate in image recognition. This is better than people, again.

So machines really are doing an extraordinarily good job of this, and it is now being used in industry. For example, Google announced last year that they had mapped every single location in France in two hours, and the way they did it was that they fed street view images into a deep learning algorithm to recognize and read street numbers. Imagine how long it would have taken before: dozens of people, many years. This is also happening in China. Baidu is kind of the Chinese Google, I guess, and what you see here in the top left is an example of a picture that I uploaded to Baidu's deep learning system, and underneath you can see that the system has understood what that picture is and found similar images. The similar images actually have similar backgrounds, similar directions of the faces, even some with their tongue out. This is not clearly looking at the text of a web page. All I uploaded was an image. So we now have computers which really understand what they see and can therefore search databases of hundreds of millions of images in real time.

So what does it mean now that computers can see? Well, it's not just that computers can see. In fact, deep learning has done more than that. Complex, nuanced sentences like this one are now understandable with deep learning algorithms. As you can see here, this Stanford-based system showing the red dot at the top has figured out that this sentence is expressing negative sentiment. Deep learning now in fact is near human performance at understanding what sentences are about and what it is saying about those things. Also, deep learning has been used to read Chinese, again at about native Chinese speaker level. This algorithm developed out of Switzerland by people, none of whom speak or understand any Chinese. As I say, using deep learning is about the best system in the world for this, even compared to native human understanding.

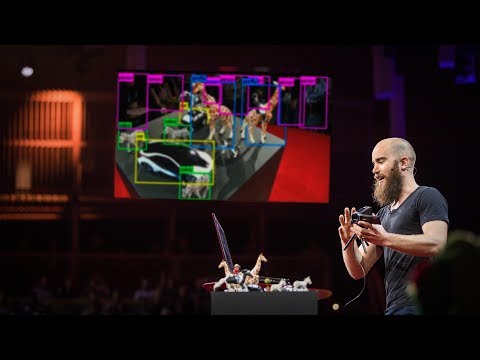

This is a system that we put together at my company which shows putting all this stuff together. These are pictures which have no text attached, and as I'm typing in here sentences, in real time it's understanding these pictures and figuring out what they're about and finding pictures that are similar to the text that I'm writing. So you can see, it's actually understanding my sentences and actually understanding these pictures. I know that you've seen something like this on Google, where you can type in things and it will show you pictures, but actually what it's doing is it's searching the webpage for the text. This is very different from actually understanding the images. This is something that computers have only been able to do for the first time in the last few months.

So we can see now that computers can not only see but they can also read, and, of course, we've shown that they can understand what they hear. Perhaps not surprising now that I'm going to tell you they can write. Here is some text that I generated using a deep learning algorithm yesterday. And here is some text that an algorithm out of Stanford generated. Each of these sentences was generated by a deep learning algorithm to describe each of those pictures. This algorithm before has never seen a man in a black shirt playing a guitar. It's seen a man before, it's seen black before, it's seen a guitar before, but it has independently generated this novel description of this picture. We're still not quite at human performance here, but we're close. In tests, humans prefer the computer-generated caption one out of four times. Now this system is now only two weeks old, so probably within the next year, the computer algorithm will be well past human performance at the rate things are going. So computers can also write.

So we put all this together and it leads to very exciting opportunities. For example, in medicine, a team in Boston announced that they had discovered dozens of new clinically relevant features of tumors which help doctors make a prognosis of a cancer. Very similarly, in Stanford, a group there announced that, looking at tissues under magnification, they've developed a machine learning-based system which in fact is better than human pathologists at predicting survival rates for cancer sufferers. In both of these cases, not only were the predictions more accurate, but they generated new insightful science. In the radiology case, they were new clinical indicators that humans can understand. In this pathology case, the computer system actually discovered that the cells around the cancer are as important as the cancer cells themselves in making a diagnosis. This is the opposite of what pathologists had been taught for decades. In each of those two cases, they were systems developed by a combination of medical experts and machine learning experts, but as of last year, we're now beyond that too. This is an example of identifying cancerous areas of human tissue under a microscope. The system being shown here can identify those areas more accurately, or about as accurately, as human pathologists, but was built entirely with deep learning using no medical expertise by people who have no background in the field. Similarly, here, this neuron segmentation. We can now segment neurons about as accurately as humans can, but this system was developed with deep learning using people with no previous background in medicine.

So myself, as somebody with no previous background in medicine, I seem to be entirely well qualified to start a new medical company, which I did. I was kind of terrified of doing it, but the theory seemed to suggest that it ought to be possible to do very useful medicine using just these data analytic techniques. And thankfully, the feedback has been fantastic, not just from the media but from the medical community, who have been very supportive. The theory is that we can take the middle part of the medical process and turn that into data analysis as much as possible, leaving doctors to do what they're best at. I want to give you an example. It now takes us about 15 minutes to generate a new medical diagnostic test and I'll show you that in real time now, but I've compressed it down to three minutes by cutting some pieces out. Rather than showing you creating a medical diagnostic test, I'm going to show you a diagnostic test of car images, because that's something we can all understand.

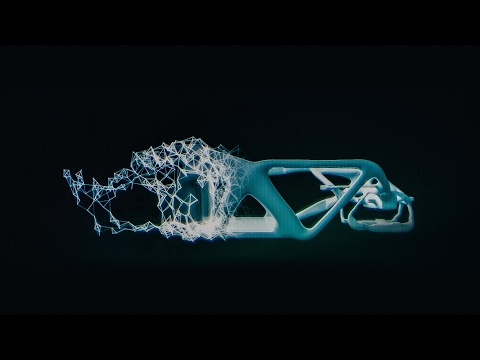

So here we're starting with about 1.5 million car images, and I want to create something that can split them into the angle of the photo that's being taken. So these images are entirely unlabeled, so I have to start from scratch. With our deep learning algorithm, it can automatically identify areas of structure in these images. So the nice thing is that the human and the computer can now work together. So the human, as you can see here, is telling the computer about areas of interest which it wants the computer then to try and use to improve its algorithm. Now, these deep learning systems actually are in 16, 000-dimensional space, so you can see here the computer rotating this through that space, trying to find new areas of structure. And when it does so successfully, the human who is driving it can then point out the areas that are interesting. So here, the computer has successfully found areas, for example, angles. So as we go through this process, we're gradually telling the computer more and more about the kinds of structures we're looking for. You can imagine in a diagnostic test this would be a pathologist identifying areas of pathosis, for example, or a radiologist indicating potentially troublesome nodules. And sometimes it can be difficult for the algorithm. In this case, it got kind of confused. The fronts and the backs of the cars are all mixed up. So here we have to be a bit more careful, manually selecting these fronts as opposed to the backs, then telling the computer that this is a type of group that we're interested in.

So we do that for a while, we skip over a little bit, and then we train the machine learning algorithm based on these couple of hundred things, and we hope that it's gotten a lot better. You can see, it's now started to fade some of these pictures out, showing us that it already is recognizing how to understand some of these itself. We can then use this concept of similar images, and using similar images, you can now see, the computer at this point is able to entirely find just the fronts of cars. So at this point, the human can tell the computer, okay, yes, you've done a good job of that.

Sometimes, of course, even at this point it's still difficult to separate out groups. In this case, even after we let the computer try to rotate this for a while, we still find that the left sides and the right sides pictures are all mixed up together. So we can again give the computer some hints, and we say, okay, try and find a projection that separates out the left sides and the right sides as much as possible using this deep learning algorithm. And giving it that hint -- ah, okay, it's been successful. It's managed to find a way of thinking about these objects that's separated out these together.

So you get the idea here. This is a case not where the human is being replaced by a computer, but where they're working together. What we're doing here is we're replacing something that used to take a team of five or six people about seven years and replacing it with something that takes 15 minutes for one person acting alone.

So this process takes about four or five iterations. You can see we now have 62 percent of our 1.5 million images classified correctly. And at this point, we can start to quite quickly grab whole big sections, check through them to make sure that there's no mistakes. Where there are mistakes, we can let the computer know about them. And using this kind of process for each of the different groups, we are now up to an 80 percent success rate in classifying the 1.5 million images. And at this point, it's just a case of finding the small number that aren't classified correctly, and trying to understand why. And using that approach, by 15 minutes we get to 97 percent classification rates.

So this kind of technique could allow us to fix a major problem, which is that there's a lack of medical expertise in the world. The World Economic Forum says that there's between a 10x and a 20x shortage of physicians in the developing world, and it would take about 300 years to train enough people to fix that problem. So imagine if we can help enhance their efficiency using these deep learning approaches?

So I'm very excited about the opportunities. I'm also concerned about the problems. The problem here is that every area in blue on this map is somewhere where services are over 80 percent of employment. What are services? These are services. These are also the exact things that computers have just learned how to do. So 80 percent of the world's employment in the developed world is stuff that computers have just learned how to do. What does that mean? Well, it'll be fine. They'll be replaced by other jobs. For example, there will be more jobs for data scientists. Well, not really. It doesn't take data scientists very long to build these things. For example, these four algorithms were all built by the same guy. So if you think, oh, it's all happened before, we've seen the results in the past of when new things come along and they get replaced by new jobs, what are these new jobs going to be? It's very hard for us to estimate this, because human performance grows at this gradual rate, but we now have a system, deep learning, that we know actually grows in capability exponentially. And we're here. So currently, we see the things around us and we say, "Oh, computers are still pretty dumb." Right? But in five years' time, computers will be off this chart. So we need to be starting to think about this capability right now.

We have seen this once before, of course. In the Industrial Revolution, we saw a step change in capability thanks to engines. The thing is, though, that after a while, things flattened out. There was social disruption, but once engines were used to generate power in all the situations, things really settled down. The Machine Learning Revolution is going to be very different from the Industrial Revolution, because the Machine Learning Revolution, it never settles down. The better computers get at intellectual activities, the more they can build better computers to be better at intellectual capabilities, so this is going to be a kind of change that the world has actually never experienced before, so your previous understanding of what's possible is different.

This is already impacting us. In the last 25 years, as capital productivity has increased, labor productivity has been flat, in fact even a little bit down.

So I want us to start having this discussion now. I know that when I often tell people about this situation, people can be quite dismissive. Well, computers can't really think, they don't emote, they don't understand poetry, we don't really understand how they work. So what? Computers right now can do the things that humans spend most of their time being paid to do, so now's the time to start thinking about how we're going to adjust our social structures and economic structures to be aware of this new reality. Thank you. (Applause)

これまではコンピューターに 何かさせようと思ったら プログラムを書く 必要がありました プログラミングはやったことが ないかもしれませんが やりたいことを 実現するために コンピューターが 行うべきことを 事細かに指定してやる 必要があります だから実現したいことの 具体的なやり方を知らずに プログラムを書くというのは 難しい話です

それがこの写真の人物 アーサー・サミュエルが直面した問題でした 1956年のこと 彼はチェッカーで 自分に勝てるプログラムを 作りたいと思いました しかしどうしたら 自分より上手く チェッカーを指す手順を 詳細に記述することができるでしょう? 彼は良い方法を 思いつきました コンピュータ自身を相手に 何千回も チェッカーの対局をさせて 自分で学ばせるんです これはうまくいきました そのプログラムは実際 1962年に コネチカット州チャンピオンを 破ることができました

だからアーサー・サミュエルは 機械学習の父とも言え 私自身 彼に 多くを負っています というのも私は機械学習の応用を 生業としているからです 私が代表を務めていた Keggleには20万人以上の 機械学習専門家が属しています Keggleでは かつて解かれたことのない課題を使って 競技会を開催していて 何百回となく 成功を収めています そのような立場から 機械学習には かつて何ができ 今何ができて 将来何ができるようになるか 多くのことを 学ぶことができました 機械学習が商業的に大きな成功を収めた 最初の例は Googleかもしれません Googleは 機械学習を使った アルゴリズムによって 情報を見つけられることを 示しました それ以来 機械学習の商業的な成功事例が たくさん生まれています AmazonやNetflixのような企業は 機械学習を使って ユーザーが買いたいであろう商品や 見たいであろう映画を 提示していて その精度は 時に不気味なくらいです LinkedInやFacebookは 知り合いかもしれない人を示唆し なぜ分かったのか 当人には 見当も付きませんが これも機械学習の力を 使っているのです 手順が事細かに プログラミングされているのではなく どうすべきかをデータから学習する アルゴリズムが使われています

IBMのワトソンが ジェパディの世界チャンピオン 2人を破ったのも そのような方法によってで ご覧のような複雑な問いに 答えることができました [2003年にこの町の国立博物館から古代の “ニムルドの獅子” が (その他多くの品とともに) 消えた] 自動運転車が実現可能になったのも 機械学習のお陰です たとえば木と歩行者を 見分けるといったことが できる必要があります そのようなことの具体的な手順が どうすれば書けるのか 分かりませんが 機械学習で可能になったのです 事実この車は 事故を起こすこともなく 普通の公道を 何百万キロも走行しています

コンピューターは 単に学べるだけでなく どうしたらできるのか 分からないようなことも 学ぶことができ 人間よりも上手くなることも あり得るのです 機械学習で最も目覚ましい 事例の1つは 私がKeggleで主催した プロジェクトで ジェフリー・ヒントン率いる トロント大のチームが 薬を発見する競技に 優勝した時です これがすごいのは 医薬大手のメルク社や この分野の専門家チームの 開発したアルゴリズムを破った彼らのチームに 化学や生物学やライフサイエンスを ちゃんと学んだ経験のある人が誰もいなかったことで しかも たった2週間で やってのけたのです どうして可能だったのか? ディープ・ラーニングと呼ばれる アルゴリズムを使ったのです ことの重大さは 数週間後に ニューヨークタイムズ紙の 一面で取り上げられたことでも 分かると思います 画面の左に出ているのが ジェフリー・ヒントンです ディープ・ラーニングというのは 人の脳の仕組みを参考にしたアルゴリズムで 何が可能かについて 理論的には限界がありません より多くのデータと 処理時間を使うほど より良い結果が得られます

ニューヨークタイムズは その記事でもう1つ ディープ・ラーニングのすごい事例を 取り上げています それをこれからお見せしましょう コンピューターが人の話を聞いて 理解できることを示すものです

(ビデオ) このプロセスの 最後に加えたいステップは 実際に中国語で 話させるということです ここで鍵になるのは 中国語話者から得た 膨大な情報を使って 中国語のテキストを 音声に変える 音声合成システムを作り 1時間ほどの 私自身の声のデータを使って そのシステムを調整し まるで私が話しているかのようにする ということです まだ完璧なものではありません たくさんミスをします (音声合成された中国語訳) (拍手) この領域で為されるべきことは まだたくさんあります (音声合成された中国語訳) (拍手)

これは中国で行われた カンファレンスでのものですが 学会で拍手が 沸き起こるというのは あまりないことです もっともTEDxは もっと自由な雰囲気がありますが ご覧いただいたものはみんな ディープ・ラーニングで実現されました (拍手) どうも 英語の文字起こしも ディープ・ラーニングだし 右上の中国語に翻訳されたテキストも ディープ・ラーニングによるもので 音声の合成にも ディープ・ラーニングが使われています

ディープ・ラーニングは このようにすごいものです 単一のアルゴリズムで ほとんど何でもできるように見えます この1年前にディープ・ラーニングが 「見る」こともできると知りました ドイツ道路標識認識ベンチマーク という奇妙な競技会で このような道路標識をディープ・ラーニングで 識別できることが示されました 他のアルゴリズムよりも 上手く識別できた というだけでなく このスコアボードにある通り 2位の人間より 2倍高い精度で 識別できたんです 2011年には コンピューターが人よりも 良く見ることができる事例が 生まれたわけです それ以来いろんなことが 起きています 2012年にGoogleが発表したんですが ディープ・ラーニング・アルゴリズムが YouTubeビデオを見て 1万6千台のコンピュータで 1ヶ月 データ処理した結果 コンピューターが「人」や 「猫」といった概念を 自分で学んだということです これは人が学習する方法に 近いものです 人は見たものを 教えられて学ぶよりは むしろそれが何なのか 自分で学んでいくものです 2012年にはまた 先ほど名前の出たジェフリー・ヒントンが 有名なImageNet競技会で 優勝しましたが これは150万の画像を 何の写真か 判別するというものです 2014年の時点で 画像認識の誤り率は 6%までになっています これも人間より高い精度です

機械はこの面で非常に良い仕事を するようになっており 商業的にも 利用されています たとえばGoogleは 去年フランス国内のすべての番地を 2時間で地図に登録したと 発表しました その方法は ストリートビューの画像を ディープ・ラーニング・アルゴリズムに食わせて 所番地を識別させるというものです かつてなら どれほど時間を 要したか分かりません 何十人掛かりで 何年もかかったでしょう こちらは中国の Baiduによるもので 中国版のGoogle のようなサービスです 左上の画像は 私がBaiduのディープ・ラーニング・システムに アップロードしたものです 下に並んでいるのは システムがその画像を理解して 似た画像を集めた結果です 類似画像は 似たような背景や 似た顔の向きを持ち 同じく舌を出してる ものまであります ウェブページの文章によって 見つけたものではありません アップしたのは 画像だけです 今やコンピュータは 見た物を理解して 何億という画像の データベースから リアルタイムで検索できるまでに なっているのです

コンピュータに「見る」ことができるというのは どんな意味を持つのか? しかしできるのは 見ることだけではありません ディープ・ラーニングには それ以上のことができます このような複雑で ニュアンスに富んだ文章を ディープ・ラーニング・アルゴリズムは 理解できます ご覧いただいているのは スタンフォード大のシステムですが 一番上の点が赤色になっていて 文が全体としてネガティブな感情を 表していることを示しています ディープ・ラーニングは今や 文章が何について何を言っているのかを 人間に近い精度で 理解できるようになっているのです ディープ・ラーニングは 中国語を読むのにも使われ 中国語のネイティブ話者並の 精度があります これを開発したのは スイスのチームですが その中に中国語の分かる人は いなかったそうです ディープ・ラーニングは これに関して ネイティブの人間にも劣らない 最も優れたシステムなのです

これは私の会社で 構築したシステムで すべてを組み合わせたものです これらの画像には テキストが紐付けされてはおらず ユーザーが文をタイプすると リアルタイムで画像を理解し 何の画像かを判別して 書き込まれた文に近い画像を 見つけます だから私の書いた文と これらの画像を 同時に理解しているわけです Googleのサイトで 似たものを見たことがあるでしょう 何かタイプすると 画像が表示されますが そこで実際に行われているのは テキストによるウェブページの検索です 画像を理解するというのとは ずいぶん違うことです このようなことが できるようになったのは ほんのここ数ヶ月のことです

コンピューターには「見る」だけでなく 「読む」こともでき 「聞く」ことによって理解できることも お見せしました そうすると「書く」ことだってできると言っても 驚かないかもしれません これは私が昨日 ディープ・ラーニング・ アルゴリズムで生成したテキストです こちらはスタンフォード大のアルゴリズムで 生成されたテキストです それぞれの画像を 説明する文が ディープ・ラーニング・アルゴリズムによって 生成されています アルゴリズムは「ギターを弾いている黒いシャツの男」を 前に見たことはありません 「男」を見たことはあり 「黒い」ものを見たことはあり 「ギター」を見たことはありますが このキャプションは画像に対して 新しく独自に作り出されたものです 書くことに関してはコンピューターは まだ人間に及びませんが 近づいています テストでは4回に1回は コンピューターの生成した文の方が好ましい ― という結果になっています このシステムはできて まだ2週間しかたっていないので このまま行くと たぶん来年中には コンピューターアルゴリズムの成績が 人間を上回るのではと思います だからコンピューターは 書くこともできるのです

これらをまとめたら 非常に興味深い可能性が開けます たとえば医療です あるボストンのチームは コンピューターによって 医師が がんの診断を する上で役に立つ 何十という腫瘍の特徴を発見したと 発表しました 同様にスタンフォードのグループは 組織の拡大画像を見て がん患者の生存率を 人間の病理医よりも 正確に予想する 機械学習システムを 開発しました どちらのケースも 予測が人間より正確というだけでなく 新たな科学的洞察を もたらしています 放射線医学のケースでは 人間に理解できる 新しい臨床的な指標です 病理学のケースでは 診断において がん細胞だけでなく がんの周囲の細胞も 重要であることを 発見しました これは病理医が 何十年も教わってきたのとは逆です どちらのケースでも システムは 医学の専門家と機械学習の専門家の 組み合わせによって開発されましたが 去年我々はこの面をも 乗り越えました これは顕微鏡で見た 人の組織から がんの領域を 識別する例です このシステムは 人間の病理医と同じか それ以上の精度で がん領域を識別できますが 医療の知識や経験のない チームによって ディープ・ラーニングを使って 開発されました 同様に これは ニューロンの区分けです 今ではニューロンを人間と 同じ正確さで区分けできますが このシステムは医学を 学んだことのない人々が ディープ・ラーニングを使って 開発しました

医学を学んだことのない人間が 医療の会社を始めるのも もはや変なことではないと思え 実際に会社を作ることにしました そうするのは 怖くもありましたが データ分析技術だけでも 有益な医療サービスは 提供可能であると 理論は示しているように見えます ありがたいことに 大変好意的な反応を受け取っており メディアばかりでなく 医学界の人々も 支持してくれています 私たちは医療の 中間部分を受け持って そこを可能な限り データ分析で置き換え 医師には彼らが最も適した部分をやってもらう というのが基本方針です 例をお見せしたいと思います 新しい医療診断テストの生成には 現在15分ほどかかります それをリアルタイムで ご覧に入れますが 一部をはしょって 3分に縮めてやります 医療診断テストを作って お見せするよりは 車の画像を診断するテストを お見せしようと思います その方が分かりやすいので

150万の車の画像から 始めます まず写真を 撮った角度によって 分類したいと思います 画像にラベルはまったく付いておらず 一から始めます ディープ・ラーニング・アルゴリズムを使って 写っている構造領域を 自動的に識別することができます これの良いところは 人とコンピューターで協力して作業できるところです ご覧のように 人が関心のある領域を コンピューターに教え コンピューターがそれに基づいて アルゴリズムを改良します このディープ・ラーニング・システムは 1万6千次元空間になっていて その空間の中で 軸を回転させて 新たな構造領域を 見つけようとします それが成功したら 人間が関心のある領域を 指摘します コンピューターがうまく 領域を見つけられました たとえば角度です このプロセスを経ることで どのような構造を 探しているのか 徐々に伝えていきます これが病気の診断であれば 病理医が病的状態にある領域を 識別するとか 放射線医が問題のある可能性のある小結節を示す といったことを想像できるでしょう 時にアルゴリズムには 難しいこともあります 今の場合 コンピューターが混乱して 前部と後部が ごちゃまぜになっています そのため少し注意して 手で前部を後部から 選り分けてやらなければなりません そうやって こんなグループに関心があるのだと コンピューターに 伝えるのです

こうやって続けていき 少しはしょりますが 機械学習アルゴリズムを 改善させるために 数百の事例を使って 訓練してやります 画像の一部が 薄れていますが これはどう理解すれば良いか 既に認識されたものです それから似たイメージという概念を 使ってやることで コンピューターが 車の前部だけを 見つけられるように なりました そうなったら 人間がコンピューターに その点で上手くできていることを 教えてやります

もちろんこの期に及んでも ある種のグループを分離するのが 難しいことがあります 今の場合 コンピューターに しばらく回転をさせても 依然として 左側と右側の画像が 混在しています コンピューターにもう 少しヒントをやり 右側と左側を可能な限り 分離できる射影を ディープ・ラーニング・ アルゴリズムを使って 見つけられるようにします そのヒントを与えることで ― 上手くいきました 右側と左側を 見分ける方法を どうにか見つけられました

基本的な考え方を 分かっていただけたと思います これは人間がコンピューターに 置き換えられるという話ではなく ― 人とコンピューターが 協力するということです やろうとしているのは これまでは5、6人のチームで 何年もかかっていた ようなことを 1人で15分ほどで できるようにする ということです

このプロセスには 4、5回の反復が必要です 150万の画像を 62%の精度で 分類できるようになりました そうなったら 大きなセクションを選んで 誤りがないか 素早くチェックできます 誤りがあった場合は コンピューターに教えてやります それぞれのグループについて そういうことを行うことで 150万の画像を 80%の精度で 分類できるようになりました そうしたら 正しく分類されなかった 少数のケースについて その理由を考えます このアプローチを 15分やることで 97%の精度で 分類できるようになりました

このようなテクニックは 世界の重要な問題を解決してくれるでしょう 世界的な医師不足です 世界経済フォーラムは 発展途上国において 医師が今の10倍から20倍必要で それだけの医師を育てるには 300年かかると言っています ディープ・ラーニングを使って 医療の効率を上げることで 対処するというのは どうでしょう?

このような機会に 私はワクワクしていますが 同時に懸念している こともあります 地図で青になっている国は 雇用の80%以上が サービス業のところです サービスとは何か? このようなものです これらのことは コンピューターが できるようになりつつあることでもあります 先進国の雇用の80%は コンピューターができるようになったことで 成り立っているのです これは何を 意味するのでしょう? 「他の仕事で置き換えられるから 問題ないよ たとえば データサイエンティストの仕事とか」 と思うかもしれませんが このようなものをデータサイエンティストが構築するのに そう時間はかかりません たとえば今回取り上げた4つのアルゴリズムは 1人の人間によって作られたものです こういうことは 以前にも起き 新しいものが現れては 古い職が新しい職で 置き換えられてきた と言うなら その新しい職は どのようなものになるのでしょう? とても難しい問題です なぜなら人間の能力は 徐々にしか向上しませんが ディープ・ラーニング・ システムの能力は 指数関数的に 向上しているからです 私達がいるのは 追い抜かれる一歩手前です 今は周りを見渡して 「コンピューターはまだ馬鹿だ」 と思っていても 5年もしたら このグラフの天井を突き破ってしまうでしょう 私たちは今この能力について 考える必要があるのです

前にも似たことは 経験しています 産業革命です エンジンの出現による 能力の急激な変化がありました しかししばらくすると 物事はまた落ち着きました 社会的な変動はありましたが あらゆる場面でエンジンが 使われるようになると 状況は安定したのです 機械学習の革命は 産業革命とは 全然違うものになるでしょう 機械学習の革命は 留まることがないからです より優れたコンピューターが 知的活動を受け持ち それによって 知的活動にさらに優れた コンピューターが作れるようになり 世界がかつて 経験したことのないような 変化を起こすことに なるでしょう 何が起こりうるかについての 以前の知見は 当てはまらないのです

この影響は既に現れています 過去25年で 資本生産性は増大しましたが 労働生産性は平坦で むしろ少し下がっています

だから この議論を 今始めて欲しいのです 私がこの状況を 説明しても なかなか真剣に 取り合ってもらえません 「コンピューターには 本当に思考することはできない」 「感情がない」 「詩を理解しない」 「我々は腦の働きを本当に理解してはいない」 などなど だったら何でしょう? 人間がお金をもらい 時間を費やして やっていたことが 機械にも可能になっているんです この新たな現実を踏まえて 社会構造や経済構造を どう調整したら良いか 考え始めるべき時です ありがとうございました (拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

10分で分かる量子コンピュータショヒーニ・ゴーシュ

2019.02.01

あなたの人生にサウンドトラックを付けてくれるAIピエール・バロー

2018.10.01

実在の人物の偽映像の作り方と、その見分け方スパソーン・スワジャナコーン

おすすめ 12018.07.25

AIはいかに人の記憶、仕事、社会生活を改善するかトム・グルーバー

2017.08.21

コンピューターはいかに物体を即座に認識できるようになったのかジョセフ・レドモン

2017.08.18

知性を持つ機械を恐れるな、協働せよガルリ・カスパロフ

2017.06.20

人工知能が人間を超えるのを怖れることはないグラディ・ブーチ

2017.03.13

直感を持った人工知能が生み出すすごい発明モーリス・コンティ

2017.02.28

表計算ソフト誕生の話ダン・ブリックリン

2017.02.01

機械知能は人間の道徳性をより重要なものにするゼイナップ・トゥフェックチー

2016.11.11

コンピューターはこうしてクリエイティブになるブレイス・アグエラ・ヤルカス

2016.07.22

Linuxの背後にある精神リーナス・トーバルズ

2016.05.03

ホログラム時代の未来にあるものアレックス・キップマン

2016.04.18

拡張現実ヘッドセットを通して未来を覗くメロン・グリベッツ

2016.04.11

形状変化テクノロジーが仕事を革新するショーン・フォルマー

2016.03.01

インターネットをスクリーンなしで見るとトム・アグロ―

2015.11.13

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ステイザ・キッド・ラロイ、ジャスティン・ビーバー

洋楽最新ヒット2021.08.20

スピーチレス~心の声ナオミ・スコット

洋楽最新ヒット2019.05.23

シェイプ・オブ・ユーエド・シーラン

洋楽人気動画2017.01.30

フェイデッドアラン・ウォーカー

洋楽人気動画2015.12.03

ウェイティング・フォー・ラヴアヴィーチー

洋楽人気動画2015.06.26

シー・ユー・アゲインウィズ・カリファ

洋楽人気動画2015.04.06

シュガーマルーン5

洋楽人気動画2015.01.14

シェイク・イット・オフテイラー・スウィフト

ポップス2014.08.18

オール・アバウト・ザット・ベースメーガン・トレイナー

ポップス2014.06.11

ストーリー・オブ・マイ・ライフワン・ダイレクション

洋楽人気動画2013.11.03

コール・ミー・メイビーカーリー・レイ・ジェプセン

洋楽人気動画2012.03.01

美しき生命コールドプレイ

洋楽人気動画2008.08.04

バッド・デイ~ついてない日の応援歌ダニエル・パウター

洋楽人気動画2008.05.14

サウザンド・マイルズヴァネッサ・カールトン

洋楽人気動画2008.02.19

イッツ・マイ・ライフボン・ジョヴィ

ロック2007.10.11

アイ・ウォント・イット・ザット・ウェイバックストリート・ボーイズ

洋楽人気動画2007.09.14

マイ・ハート・ウィル・ゴー・オンセリーヌ・ディオン

洋楽人気動画2007.07.12

ヒーローマライア・キャリー

洋楽人気動画2007.03.21

オールウェイズ・ラヴ・ユーホイットニー・ヒューストン

洋楽人気動画2007.02.19

オネスティビリー・ジョエル

洋楽人気動画2005.09.16