TED日本語

TED Talks(英語 日本語字幕付き動画)

TED日本語 - フェイフェイ・リー: コンピュータが写真を理解するようになるまで

TED Talks

コンピュータが写真を理解するようになるまで

How we're teaching computers to understand pictures

フェイフェイ・リー

Fei Fei Li

内容

小さな子供は写真を見て「ネコ」や「本」や「椅子」のような簡単な要素を識別できます。今やコンピュータも同じことができるくらいに賢くなりました。次は何でしょう?この胸躍る講演で、コンピュータビジョンの専門家であるフェイフェイ・リーが、写真を理解できるようコンピュータに「教える」ために構築された1500万の画像データベースをはじめとする、この分野の最先端と今後について語ります。

字幕

SCRIPT

Script

Let me show you something.

(Video) Girl: Okay, that's a cat sitting in a bed. The boy is petting the elephant. Those are people that are going on an airplane. That's a big airplane.

Fei-Fei Li: This is a three-year-old child describing what she sees in a series of photos. She might still have a lot to learn about this world, but she's already an expert at one very important task: to make sense of what she sees. Our society is more technologically advanced than ever. We send people to the moon, we make phones that talk to us or customize radio stations that can play only music we like. Yet, our most advanced machines and computers still struggle at this task. So I'm here today to give you a progress report on the latest advances in our research in computer vision,one of the most frontier and potentially revolutionary technologies in computer science.

Yes, we have prototyped cars that can drive by themselves, but without smart vision, they can not really tell the difference between a crumpled paper bag on the road, which can be run over, and a rock that size, which should be avoided. We have made fabulous megapixel cameras, but we have not delivered sight to the blind. Drones can fly over massive land, but don't have enough vision technology to help us to track the changes of the rainforests. Security cameras are everywhere, but they do not alert us when a child is drowning in a swimming pool. Photos and videos are becoming an integral part of global life. They're being generated at a pace that's far beyond what any human, or teams of humans, could hope to view, and you and I are contributing to that at this TED. Yet our most advanced software is still struggling at understanding and managing this enormous content. So in other words, collectively as a society, we're very much blind, because our smartest machines are still blind.

"Why is this so hard?" you may ask. Cameras can take pictures like this one by converting lights into a two-dimensional array of numbers known as pixels, but these are just lifeless numbers. They do not carry meaning in themselves. Just like to hear is not the same as to listen, to take pictures is not the same as to see, and by seeing, we really mean understanding. In fact, it took Mother Nature 540 million years of hard work to do this task, and much of that effort went into developing the visual processing apparatus of our brains, not the eyes themselves. So vision begins with the eyes, but it truly takes place in the brain.

So for 15 years now, starting from my Ph.D. at Caltech and then leading Stanford's Vision Lab, I've been working with my mentors, collaborators and students to teach computers to see. Our research field is called computer vision and machine learning. It's part of the general field of artificial intelligence. So ultimately, we want to teach the machines to see just like we do: naming objects, identifying people, inferring 3D geometry of things, understanding relations, emotions, actions and intentions. You and I weave together entire stories of people, places and things the moment we lay our gaze on them.

The first step towards this goal is to teach a computer to see objects, the building block of the visual world. In its simplest terms, imagine this teaching process as showing the computers some training images of a particular object, let's say cats, and designing a model that learns from these training images. How hard can this be? After all, a cat is just a collection of shapes and colors, and this is what we did in the early days of object modeling. We'd tell the computer algorithm in a mathematical language that a cat has a round face, a chubby body,two pointy ears, and a long tail, and that looked all fine. But what about this cat? (Laughter) It's all curled up. Now you have to add another shape and viewpoint to the object model. But what if cats are hidden? What about these silly cats? Now you get my point. Even something as simple as a household pet can present an infinite number of variations to the object model, and that's just one object.

So about eight years ago, a very simple and profound observation changed my thinking. No one tells a child how to see, especially in the early years. They learn this through real-world experiences and examples. If you consider a child's eyes as a pair of biological cameras, they take one picture about every 200 milliseconds, the average time an eye movement is made. So by age three, a child would have seen hundreds of millions of pictures of the real world. That's a lot of training examples. So instead of focusing solely on better and better algorithms, my insight was to give the algorithms the kind of training data that a child was given through experiences in both quantity and quality.

Once we know this, we knew we needed to collect a data set that has far more images than we have ever had before, perhaps thousands of times more, and together with Professor Kai Li at Princeton University, we launched the ImageNet project in 2007. Luckily, we didn't have to mount a camera on our head and wait for many years. We went to the Internet, the biggest treasure trove of pictures that humans have ever created. We downloaded nearly a billion images and used crowdsourcing technology like the Amazon Mechanical Turk platform to help us to label these images. At its peak, ImageNet was one of the biggest employers of the Amazon Mechanical Turk workers: together, almost 50,000 workers from 167 countries around the world helped us to clean, sort and label nearly a billion candidate images. That was how much effort it took to capture even a fraction of the imagery a child's mind takes in in the early developmental years.

In hindsight, this idea of using big data to train computer algorithms may seem obvious now, but back in 2007, it was not so obvious. We were fairly alone on this journey for quite a while. Some very friendly colleagues advised me to do something more useful for my tenure, and we were constantly struggling for research funding. Once, I even joked to my graduate students that I would just reopen my dry cleaner's shop to fund ImageNet. After all, that's how I funded my college years.

So we carried on. In 2009, the ImageNet project delivered a database of 15 million images across 22,000 classes of objects and things organized by everyday English words. In both quantity and quality, this was an unprecedented scale. As an example, in the case of cats, we have more than 62,000 cats of all kinds of looks and poses and across all species of domestic and wild cats. We were thrilled to have put together ImageNet, and we wanted the whole research world to benefit from it, so in the TED fashion, we opened up the entire data set to the worldwide research community for free. (Applause)

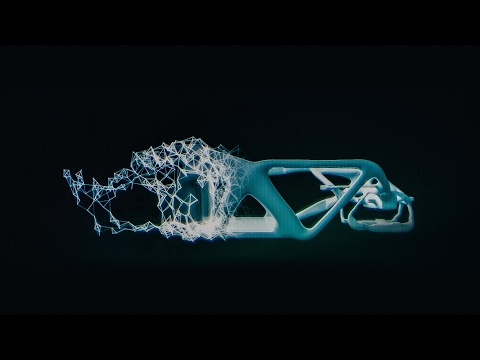

Now that we have the data to nourish our computer brain, we're ready to come back to the algorithms themselves. As it turned out, the wealth of information provided by ImageNet was a perfect match to a particular class of machine learning algorithms called convolutional neural network, pioneered by Kunihiko Fukushima, Geoff Hinton, and Yann LeCun back in the 1970s and '80s. Just like the brain consists of billions of highly connected neurons, a basic operating unit in a neural network is a neuron-like node. It takes input from other nodes and sends output to others. Moreover, these hundreds of thousands or even millions of nodes are organized in hierarchical layers, also similar to the brain. In a typical neural network we use to train our object recognition model, it has 24 million nodes,140 million parameters, and 15 billion connections. That's an enormous model. Powered by the massive data from ImageNet and the modern CPUs and GPUs to train such a humongous model, the convolutional neural network blossomed in a way that no one expected. It became the winning architecture to generate exciting new results in object recognition. This is a computer telling us this picture contains a cat and where the cat is. Of course there are more things than cats, so here's a computer algorithm telling us the picture contains a boy and a teddy bear; a dog, a person, and a small kite in the background; or a picture of very busy things like a man, a skateboard, railings, a lampost, and so on. Sometimes, when the computer is not so confident about what it sees, we have taught it to be smart enough to give us a safe answer instead of committing too much, just like we would do, but other times our computer algorithm is remarkable at telling us what exactly the objects are, like the make, model, year of the cars.

We applied this algorithm to millions of Google Street View images across hundreds of American cities, and we have learned something really interesting: first, it confirmed our common wisdom that car prices correlate very well with household incomes. But surprisingly, car prices also correlate well with crime rates in cities, or voting patterns by zip codes.

So wait a minute. Is that it? Has the computer already matched or even surpassed human capabilities? Not so fast. So far, we have just taught the computer to see objects. This is like a small child learning to utter a few nouns. It's an incredible accomplishment, but it's only the first step. Soon, another developmental milestone will be hit, and children begin to communicate in sentences. So instead of saying this is a cat in the picture, you already heard the little girl telling us this is a cat lying on a bed.

So to teach a computer to see a picture and generate sentences, the marriage between big data and machine learning algorithm has to take another step. Now, the computer has to learn from both pictures as well as natural language sentences generated by humans. Just like the brain integrates vision and language, we developed a model that connects parts of visual things like visual snippets with words and phrases in sentences.

About four months ago, we finally tied all this together and produced one of the first computer vision models that is capable of generating a human-like sentence when it sees a picture for the first time. Now, I'm ready to show you what the computer says when it sees the picture that the little girl saw at the beginning of this talk.

(Video) Computer: A man is standing next to an elephant. A large airplane sitting on top of an airport runway.

FFL: Of course, we're still working hard to improve our algorithms, and it still has a lot to learn. (Applause)

And the computer still makes mistakes.

(Video) Computer: A cat lying on a bed in a blanket.

FFL: So of course, when it sees too many cats, it thinks everything might look like a cat.

(Video) Computer: A young boy is holding a baseball bat. (Laughter)

FFL: Or, if it hasn't seen a toothbrush, it confuses it with a baseball bat.

(Video) Computer: A man riding a horse down a street next to a building. (Laughter)

FFL: We haven't taught Art 101 to the computers.

(Video) Computer: A zebra standing in a field of grass.

FFL: And it hasn't learned to appreciate the stunning beauty of nature like you and I do.

So it has been a long journey. To get from age zero to three was hard. The real challenge is to go from three to 13 and far beyond. Let me remind you with this picture of the boy and the cake again. So far, we have taught the computer to see objects or even tell us a simple story when seeing a picture.

(Video) Computer: A person sitting at a table with a cake.

FFL: But there's so much more to this picture than just a person and a cake. What the computer doesn't see is that this is a special Italian cake that's only served during Easter time. The boy is wearing his favorite t-shirt given to him as a gift by his father after a trip to Sydney, and you and I can all tell how happy he is and what's exactly on his mind at that moment.

This is my son Leo. On my quest for visual intelligence, I think of Leo constantly and the future world he will live in. When machines can see, doctors and nurses will have extra pairs of tireless eyes to help them to diagnose and take care of patients. Cars will run smarter and safer on the road. Robots, not just humans, will help us to brave the disaster zones to save the trapped and wounded. We will discover new species, better materials, and explore unseen frontiers with the help of the machines.

Little by little, we're giving sight to the machines. First, we teach them to see. Then, they help us to see better. For the first time, human eyes won't be the only ones pondering and exploring our world. We will not only use the machines for their intelligence, we will also collaborate with them in ways that we can not even imagine.

This is my quest: to give computers visual intelligence and to create a better future for Leo and for the world.

Thank you.

(Applause)

まずこのビデオを ご覧ください

(女の子の声) ネコがベッドに座ってる 男の子が象をなでてる 飛行機へ行く人たち 大きな飛行機よ

(講演者) これは3歳児が 見た写真を 説明しているところです 彼女にはこの世界で学ぶことが まだまだあるかもしれませんが ひとつの重要な作業については すでにエキスパートです 見たものを理解する ということです 私たちの社会は技術的に かつてなく進歩しています 月へと人を送り込み 人に話しかける電話を作り 自分の好きな曲だけがかかるように ラジオをカスタマイズしています しかしながら最先端の コンピュータでも まだこの作業には 手こずっているんです 私は今日コンピュータビジョンの 最新動向について お伝えするために来ました これはコンピュータサイエンスの中でも 先端にあって 画期的なものになる 可能性のある技術です

自分で運転する車の プロトタイプが作られていますが 知的な視覚処理能力がなかったら 踏みつぶしても問題のない 道路上の丸めた紙袋と 避けて通るべき同じ大きさの石とを 見分けることもできません すごいメガピクセルの カメラが作られていますが 盲目の人に視力を与えることは できていません 無人機を広大な土地の上に 飛ばすことはできても 熱帯雨林の変化を 追跡できるだけの 画像技術はまだありません 監視カメラが至る所に 設置されていますが プールで溺れている子がいても 警告してはくれません 写真やビデオは世界において 生活に不可欠な一部をなしています どんな個人であれ チームであれ 見切れないほどのペースで 映像が量産されています そして私たちも ここTEDで それに貢献しています しかし最も進んだ ソフトウェアでさえ この膨大な映像を理解し管理するのに 手こずっています 言ってみれば 私たちの社会は 集合的に盲目であり それは最も知的な機械が いまだ盲目だからです

なぜそんなに難しいのかと 思うかもしれません カメラはこのような写真を撮って 光をピクセルと呼ばれる 数字の2次元配列へと 変換しますが これは死んだ数字の列に 過ぎません 数字自体に意味はありません 単に音が耳に入ってくるのと 「聴く」のとは違うように 「写真を撮る」のと「見る」のとは 同じではありません 「見る」ということには 理解することが含まれているのです 実際この仕事を 成し遂げられるようにするために 母なる自然は 5億4千万年という 長い歳月を必要としたのです そしてその努力の多くは 目そのものではなく 脳の視覚処理能力を発達させるために 費やされました 視覚というのは 目から始まりますが それが本当に起きているのは 脳の中なのです

これまで15年間 カリフォルニア工科大学の博士課程の頃から スタンフォード大でコンピュータビジョン研究室を 率いている今に到るまで 私は指導教官や共同研究者や 学生達とともに コンピュータに見ることを 教えようとしてきました 私たちの研究領域は コンピュータビジョンと機械学習で これは人工知能の分野の一部です 最終的に私たちがしたいのは 機械も人間のようにものを見られるようにすることです 物が何か言い当て 人を識別し 3次元的な配置を推量し 関係や感情や行動や意図を 理解するということです 私たち人間は一目見ただけで 人 場所 物の織りなす物語全体を 捉えることができます

この目標に向けた第一歩は コンピュータに視覚世界の構成要素である物を 見られるようにすることです 簡単に言うと ネコのような特定の物の 訓練用画像を コンピュータに与えて それらの画像から学習する モデルを設計するんです 簡単そうに聞こえますよね? ネコの画像は色と形の 集まりに過ぎません これは初期のオブジェクト・モデリングで 私たちがやっていたことでした 数学的な言語を使って コンピュータアルゴリズムに ネコには 丸い顔と ぽっちゃりした体と 2つのとがった耳と 長いしっぽがあると教え それでうまくいきそうでした でもこのネコはどうでしょう? (笑) 体がすっかり反り返っています オブジェクトモデルに新しい形と視点を 追加する必要があります でもネコが一部隠れていたら どうでしょう? このおかしなネコたちはどうでしょう? 言いたいこと分かりますよね? 身近なペットのネコという シンプルなものでさえ オブジェクトモデルに 無数のバリエーションを定義する必要があり しかもこれは沢山あるものの 1つに過ぎないんです

8年ほど前 とてもシンプルながら本質的なある観察が 私の考え方を変えました 子供は教えられなくても 成長の初期に ものの見方を身に付けるということです 子供は現実の世界における 経験と例を通して学ぶのです 子供の目が 生きたカメラで 200ミリ秒ごとに1枚 写真を撮っていると 考えてみましょう これは目が動く 平均時間です すると子供は3歳になるまでに 何億枚という 現実世界の写真を 見ていることになります 膨大な量の訓練例です それで気が付いたのは アルゴリズムの改良ばかりに集中するのではなく 子供が経験を通じて 受け取るような 量と質の訓練データを アルゴリズムに与えてはどうか ということでした

このことに気付いた時 私たちが持っているよりも 遙かに多くの画像データを 集めなければならないことが 明らかでした 何千倍も必要です それで私はプリンストン大学の カイ・リー教授と一緒に 2007年にImageNetプロジェクトを 立ち上げました 幸い私たちは 頭にカメラを付けて 何年も歩き回る必要は ありませんでした 人類がかつて作った 最大の画像の宝庫 インターネットに 向かったのです 私たちは10億枚近い画像を ダウンロードし アマゾン・メカニカル・タークのような クラウドソーシング技術を使って それらの画像に ラベル付けをしました 最盛期にはImageNetは アマゾン・メカニカル・ターク作業者の 最大の雇用者の1つに なっていました 167カ国の 5万人近い作業者が 10億枚近い画像を 整理しラベル付けする作業に 携わりました 子供がその成長の初期に 受け取るのに 匹敵する量の画像を 用意するためには それほどの労力が 必要だったのです

コンピュータアルゴリズムの訓練に ビッグデータを使うというアイデアは 今からすると 自明なものに見えるでしょうが 2007年当時は そうではありませんでした かなり長い間 こんなことをやっている人は 私たち以外にいませんでした 親切な同僚が将来の職のためにもう少し有用なことを した方がいいとアドバイスしてくれたくらいです 研究資金には いつも困っていました ImageNetの資金調達のために クリーニング屋をまた開こうかしらと 学生に冗談で言ったくらいです 私が学生の頃 学費のために やっていたことです

私たちは進み続け 2009年に ImageNetプロジェクトは 日常的な英語を使って 2万2千のカテゴリに分類した 1500万枚の画像の データベースを 完成させました これは量という点でも 質という点でも かつてないスケールのものでした 一例を挙げると ネコの画像は 6万2千点以上あって 様々な見かけや ポーズのネコがいて 飼い猫から山猫まで あらゆる種類を網羅しています 私たちはImageNetが できあがったことを喜び 世界の研究者にも その恩恵を受けて欲しいと思い TEDの流儀で データセットをまるごと 無償で世界の研究者コミュニティに 公開しました (拍手)

こうしてコンピュータの脳を 育てるためのデータができ アルゴリズムに取り組む 用意が整いました それで分かったのは ImageNetが提供する豊かな情報に適した 機械学習アルゴリズムがあることです 畳み込みニューラルネットワークと言って 福島邦彦 ジェフリー・ヒントン ヤン・ルカンといった人たちが 1970年代から1980年代にかけて 開拓した領域です 脳が何十億という高度に結合し合った ニューロンからできているように ニューラルネットワークの 基本要素となっているのは ニューロンのようなノードです 他のノードからの入力を受けて 他のノードへ出力を渡します 何十万 何百万という このようなノードが これも脳と同様に 階層的に組織化されています 物を認識するモデルを訓練するために 私たちが通常使うニューラルネットワークには 2千4百万のノード 1億4千万のパラメータ 150億の結合があります ものすごく大きなモデルです ImageNetの膨大なデータと 現代のCPUやGPUの性能を使って このような巨大なモデルを訓練することで 畳み込みニューラルネットワークは 誰も予想しなかったくらいに 大きく花開きました これは物の認識において 目覚ましい結果を出す 大当たりのアーキテクチャとなっています ここではコンピュータが 写真の中にネコがいることと その場所を示しています もちろんネコ以外のものも 認識できます こちらではコンピュータアルゴリズムが 写真の中に男の子とテディベアが 写っていることを教えています 犬と 人物と 後方に小さな凧が あることを示しています とても沢山のものが 写った写真から 男性 スケートボード 手すり 街灯などを見分けています 写っているものが何なのか コンピュータが そんなに自信を持てない場合もあります [動物] コンピュータには 当て推量をするよりは 確かなところを答えるよう 教えています ちょうど私たち自身がするように 一方で何が写っているかについて コンピュータアルゴリズムが 驚くほど正確に 言い当てることもあります たとえば自動車の車種や モデルや年式のような

このアルゴリズムを アメリカの数百都市の 何百万という Googleストリートビュー画像に適用した結果 面白い発見がありました まず 車の値段は 家計収入とよく相関しているという 予想が裏付けられました でも驚いたことに 車の値段は 街の犯罪率とも よく相関していたんです それはまた郵便番号区域ごとの 投票傾向とも相関しています

それでは コンピュータは 既に人間の能力に追いつき 追い越しているのでしょうか? 結論を急がないで これまでのところ 私たちは コンピュータに物の見方を教えただけです 小さな子供が名詞をいくつか 言えるようになったようなものです ものすごい成果ですが まだ第一歩にすぎず 次の開発目標があります 子供は文章でコミュニケーションを するようになります だから写真を見て小さな女の子が 単にネコと言わずに ネコがベッドに座っていると 言うのを聞いたわけです

コンピュータが写真を見て 文章を作れるよう教えるために このビッグデータと 機械学習の結びつきが 新たなステップを 踏む必要があります コンピュータは 写真だけでなく 人が発する自然言語の文章も 学ぶ必要があります 脳が視覚と言語を 結びつけるように 画像の断片のような 視覚的なものの一部と 文章の中の単語やフレーズを 繋ぎ合わせるモデルを 私たちは開発しました

4ヶ月ほど前 ついに私たちは すべてをまとめ 初めて見た写真について 人が書いたような 記述文を生成できる 最初のコンピュータ・ビジョン・ モデルを作り上げました 冒頭で小さな女の子が説明したのと 同じ写真を見て そのコンピュータが何と言ったか お見せしましょう

「ゾウの横に立っている男」 「空港の滑走路にいる大きな飛行機」

私たちは今もアルゴリズムを改良しようと 熱心に取り組んでいて 学ぶべきことは まだまだあります (拍手)

コンピュータは まだ間違いを犯します

「ベッドの上の毛布の中のネコ」

ネコを沢山見過ぎたせいで 何でもネコみたいに 見えるのかもしれません

「野球バットを持つ小さな男の子」 (笑)

歯ブラシを見たことがないと 野球バットと混同してしまいます

「建物脇の道を馬に乗って行く男」 (笑)

美術はまだコンピュータに 教えていませんでした

「草原に立つシマウマ」

私たちのように 自然の美を慈しむことは まだ学んでいません

長い道のりでした 0歳から3歳まで行くのは 大変でした でも本当の挑戦は3歳から13歳 さらにその先へと行くことです あの男の子とケーキの写真を もう一度見てみましょう 私たちはコンピュータに 物を識別することを教え 写真を簡単に説明することさえ 教えました

「ケーキのあるテーブルにつく人」

しかしこの写真には 単に人とケーキというよりも 遙かに多くのものがあります コンピュータが見なかったのは このケーキが特別なイタリアのケーキで イースターの時に 食べるものだということです 男の子が着ているのは お気に入りのTシャツで お父さんがシドニー旅行の おみやげにくれたものだということ 私たちはみんな この男の子がどんなに喜んでいるか 何を思っているかが分かります

これは息子のレオです 視覚的な知性を 追い求める探求の中で 私はいつもレオのことや レオが住むであろう 未来の世界のことを考えています 機械に見ることが できるようになれば 医師や看護師は疲れを知らない 別の目を手に入れて 患者の診断や世話に 役立てられるでしょう 自動車は道路をより賢明に 安全に走行するようになるでしょう 人間だけでなくロボットも 災害地域に取り残され負傷した人々を救出する 手助けができるようになるでしょう 私たちは機械の助けを借りて 新種の生物やより優れた素材を発見し 未だ見ぬフロンティアを 探検するようになるでしょう

私たちは少しずつ機械に 視覚を与えています 最初に私たちが 機械に見ることを教え それから機械が より良く見られるよう 私たちを助けてくれることでしょう 歴史上初めて 人間以外の目が 世界について考察し 探求するようになるのです 私たちは機械の知性を 利用するだけでなく 想像もできないような方法で 機械と人間が協力し合うようになるでしょう

私が追い求めているのは コンピュータに視覚的な知性を与え レオや世界のために より良い未来を作り出すということです

ありがとうございました

(拍手)

品詞分類

- 主語

- 動詞

- 助動詞

- 準動詞

- 関係詞等

TED 日本語

TED Talks

関連動画

10分で分かる量子コンピュータショヒーニ・ゴーシュ

2019.02.01

あなたの人生にサウンドトラックを付けてくれるAIピエール・バロー

2018.10.01

実在の人物の偽映像の作り方と、その見分け方スパソーン・スワジャナコーン

おすすめ 12018.07.25

AIはいかに人の記憶、仕事、社会生活を改善するかトム・グルーバー

2017.08.21

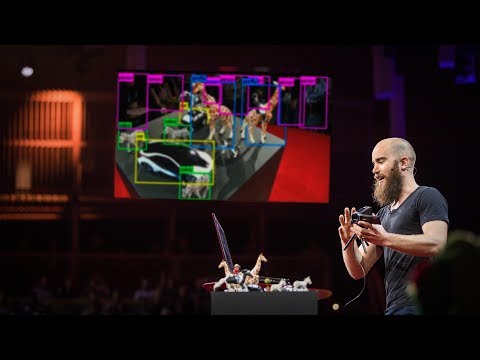

コンピューターはいかに物体を即座に認識できるようになったのかジョセフ・レドモン

2017.08.18

知性を持つ機械を恐れるな、協働せよガルリ・カスパロフ

2017.06.20

人工知能が人間を超えるのを怖れることはないグラディ・ブーチ

2017.03.13

直感を持った人工知能が生み出すすごい発明モーリス・コンティ

2017.02.28

表計算ソフト誕生の話ダン・ブリックリン

2017.02.01

機械知能は人間の道徳性をより重要なものにするゼイナップ・トゥフェックチー

2016.11.11

コンピューターはこうしてクリエイティブになるブレイス・アグエラ・ヤルカス

2016.07.22

Linuxの背後にある精神リーナス・トーバルズ

2016.05.03

ホログラム時代の未来にあるものアレックス・キップマン

2016.04.18

拡張現実ヘッドセットを通して未来を覗くメロン・グリベッツ

2016.04.11

形状変化テクノロジーが仕事を革新するショーン・フォルマー

2016.03.01

インターネットをスクリーンなしで見るとトム・アグロ―

2015.11.13

洋楽 おすすめ

RECOMMENDS

洋楽歌詞

ステイザ・キッド・ラロイ、ジャスティン・ビーバー

洋楽最新ヒット2021.08.20

スピーチレス~心の声ナオミ・スコット

洋楽最新ヒット2019.05.23

シェイプ・オブ・ユーエド・シーラン

洋楽人気動画2017.01.30

フェイデッドアラン・ウォーカー

洋楽人気動画2015.12.03

ウェイティング・フォー・ラヴアヴィーチー

洋楽人気動画2015.06.26

シー・ユー・アゲインウィズ・カリファ

洋楽人気動画2015.04.06

シュガーマルーン5

洋楽人気動画2015.01.14

シェイク・イット・オフテイラー・スウィフト

ポップス2014.08.18

オール・アバウト・ザット・ベースメーガン・トレイナー

ポップス2014.06.11

ストーリー・オブ・マイ・ライフワン・ダイレクション

洋楽人気動画2013.11.03

コール・ミー・メイビーカーリー・レイ・ジェプセン

洋楽人気動画2012.03.01

美しき生命コールドプレイ

洋楽人気動画2008.08.04

バッド・デイ~ついてない日の応援歌ダニエル・パウター

洋楽人気動画2008.05.14

サウザンド・マイルズヴァネッサ・カールトン

洋楽人気動画2008.02.19

イッツ・マイ・ライフボン・ジョヴィ

ロック2007.10.11

アイ・ウォント・イット・ザット・ウェイバックストリート・ボーイズ

洋楽人気動画2007.09.14

マイ・ハート・ウィル・ゴー・オンセリーヌ・ディオン

洋楽人気動画2007.07.12

ヒーローマライア・キャリー

洋楽人気動画2007.03.21

オールウェイズ・ラヴ・ユーホイットニー・ヒューストン

洋楽人気動画2007.02.19

オネスティビリー・ジョエル

洋楽人気動画2005.09.16